#80 Dois Novos Modelos de Geração de Vídeos, Lançamento do ChatGPT Canvas e State of AI Report 2024

Seja bem-vindo(a) a mais uma newsletter do Revolução AI. Aqui você não perde nada sobre o universo das Inteligências Artificiais Generativas!

Peço desculpas por termos estado ausentes nos últimos dias - tivemos alguns contratempos - mas estamos de volta!

E a edição de hoje está cheia de assuntos interessantes e relevantes! Os temas de hoje são:

Dois novos modelos de geração de vídeos com AI; Lançamento do ChatGPT Canvas; State of AI Report 2024; Baixe o app do ChatGPT para Windows; Acesse os principais modelos de vídeo e imagem em um só lugar.

News

Dois novos modelos de geração de vídeos com AI

Dois novos modelos de geração de vídeo com Inteligência Artificial foram lançados recentemente.

Ambos os modelos são de empresas já conhecidas no meio das AIs - Meta e Pika Labs - e se chamam Meta Movie Gen e Pika 1.5.

Eles se juntam à categoria seleta, porém crescente, dos modelos de vídeo do nível do Sora, da OpenAI. Nesta categoria, temos Veo, Kling, Minimax, Firefly Video, Gen-3 e Dream Machine.

Cada um destes modelos, apesar de serem bastante comparáveis, possuem características, vantagens e desvantagens únicas.

Então vamos conhecer os dois novos entrantes na cena.

Meta Movie Gen

Começando pelo modelo da Meta, o Movie Gen foi anunciado no início deste mês e é capaz de gerar vídeos de até 16 segundos (em 16 frames por segundo), em HD 1080p, a partir de comandos de texto.

Além disso, o modelo consegue criar vídeos em diferentes formatos (paisagem, retrato, etc.).

A qualidade dos vídeos gerados por ele é muito boa, principalmente em realismo (a maior parte dos exemplos disponibilizados pela Meta são de realismo, então é difícil mensurar sua capacidade em outros estilos, como animação e desenho).

Você pode ver alguns exemplos por aqui.

E os vídeos têm uma consistência temporal boa, ou seja, os objetos costumam se manter os mesmos ao longo do vídeo.

Contudo, o que é mais interessante no Movie Gen não é a qualidade do que ele gera - existem modelos até melhores - , mas as funcionalidades que a Meta incorporou nele.

Assim, o modelo permite que o usuário:

Edite vídeos com texto: permite modificar vídeos existentes através de prompts de texto, ajustando estilos visuais, transições e realizando edições detalhadas com precisão. Assim, basta enviar um vídeo e escrever as alterações que deseja que a AI faça (“troque a cor do carro”, “mude o estilo para desenho a lápis”, “altere o fundo para um estádio de futebol”).

Produza vídeos personalizados: com essa funcionalidade, o usuário pode fazer o upload de uma foto sua e escrever um prompt. A pessoa no vídeo que for gerado terá o rosto deste usuário, com suas características físicas muito bem preservados e incorporadas no contexto do vídeo. É bem legal.

Gere efeitos de som e trilhas sonoras: possibilita criar efeitos sonoros e trilhas que complementam os vídeos, oferecendo a capacidade de estender, ajustar e personalizar o áudio gerado para enriquecer o que foi produzido.

No geral, o modelo da Meta é bem interessante e, com suas funcionalidades, traz novidades em relação ao que existia no mercado.

Por enquanto, ele não está disponível para ser acessado publicamente, mas deve ser liberado em breve. Se você quiser ler mais sobre ele é só clicar aqui.

Pika 1.5

Falando agora do outro modelo, o Pika 1.5 é o segundo modelo lançado pela Pika Labs.

A empresa foi fundada em meados de 2023 e no final deste mesmo ano lançou o Pika 1.0.

O modelo era um dos melhores na época, mas, rapidamente, ficou defasado com o lançamento do Sora e dos outros modelos de segunda geração.

Assim, o Pika 1.5 é uma grande atualização.

O novo modelo traz melhorias significativas na qualidade dos vídeos gerados - resolução, aderência a comandos e consistência temporal.

A mudança mais importante em relação à versão anterior diz respeito ao realismo das imagens e animações. Isso pois agora elas possuem maior detalhamento, textura e suavidade nos movimentos.

A qualidade dos vídeos é realmente muito boa. Particularmente, eu gosto dessa AI para gerar animações - não tanto para vídeos muito realistas (o contrário do modelo da Meta).

Junto do novo modelo, a Pika Labs também lançou uma série de efeitos de vídeo que podem ser criados usando o Pika 1.5.

Ela os chamou de Pikaeffects.

Basta enviar uma imagem, escolher o efeito que deseja aplicar e esperar pelo vídeo gerado. Cada efeito tem características específicas que permitem transformar imagens em vídeo de forma criativa.

Eles são oito no total:

Inflate It: este efeito faz com que objetos ou personagens na imagem se expandam como balões inflando.

Explode It: simula uma explosão, com os objetos no vídeo sendo destruídos e arremessados em várias direções.

Crush It: simula o esmagamento de objetos, como se fossem comprimidos por uma força externa.

Melt It: transforma a aparência de um objeto, como se ele estivesse derretendo.

Squish It: comprime ou distorce objetos, como se eles fossem uma massa de modelar.

Cake-ify It: transforma objetos em bolos. O efeito simula cortes no objeto, revelando camadas internas, como se o objeto fosse realmente um bolo sendo cortado.

Ta-da-it: como um efeito de revelação dramática, ele faz com que objetos se materializem com flashes de luz ou partículas, criando uma entrada impactante na cena.

Deflate It: inverso ao Inflate It, faz com que objetos percam volume como um balão esvaziando.

Crumble It: quebra objetos em fragmentos menores.

Dissolve It: Desaparece com o objeto, transformando-o em partículas que se dissipam lentamente.

Você pode ver esses efeitos na prática clicando aqui. É bem divertido.

Além disso, o Pika 1.5 vem com configurações avançadas de câmera. Chamadas de Big Screen Shots, elas simulam estilos cinematográficos.

São 5 efeitos de câmera que podem ser adicionados ao prompt no momento de gerar um vídeo: Bullet Time, câmera lenta dramática ao redor do objeto, Crash Zoom, zoom rápido para destacar elementos, Crane Up, movimento ascendente para revelar mais da cena, Whip Pan, transições horizontais rápidas, e 360° Camera Movement, visão completa ao redor de objetos ou personagem.

O resultado é bem interessante e dá muito mais controle criativo ao usuário.

Um ponto que continua sendo negativo na nova versão do Pika é a curta duração dos vídeos gerados, que se mantém de apenas 5 segundos.

O Pika pode ser acessado por aqui e qualquer um pode gerar vídeos gratuitamente com ele (limitado aos 150 créditos mensais fornecidos pela empresa).

Vale a pena experimentar - mas tenha paciência, pois a gerações demoram bastante.

Uma tendência legal que estamos observando é que os modelos recentes, além de virem melhorados em termos de qualidade, estão vindo com uma série de funcionalidades e ferramentas que auxiliam a criação.

E isso é fundamental para que, cada vez mais, a AI seja adotada na produção audiovisual profissional.

Lançamento do ChatGPT Canvas

Há alguns dias, a OpenAI anunciou o ChatGPT Canvas.

O Canvas é uma nova funcionalidade dentro do ChatGPT que melhorará a experiência do usuário em tarefas que envolvem redação de textos e escrita de códigos.

Ele foi desenvolvido para solucionar uma limitação da maior parte dos chatbots de AI: a dificuldade de lidar com tarefas que exigem revisões e edições contínuas. Isto é, a interface de chat não é a ideal para gerar e modificar textos ou códigos.

Até então, as tarefas de escrita no ChatGPT seguiam processos como este: “você pede para a AI gerar um texto > recebe o texto gerado > pede uma modificação pontual > recebe um texto inteiro gerado novamente > cola o texto no Docs > faz uma modificação no texto > pensa em uma nova alteração para a AI fazer > precisa enviar o texto na conversa > recebe a alteração > cola o texto novamente > …”.

Este processo não é muito natural, nem eficiente.

A interface ideal para esse tipo de tarefas é algo como um Google Docs ou Word integrado com Inteligência Artificial. Nessa interface, tanto você quanto a AI poderia escrever o texto de maneira colaborativa.

E o mesmo vale para tarefas de programação.

Assim, a OpenAI criou o Canvas para, como o nome já diz, ser uma tela de de colaboração.

Basicamente, quando o usuário tem selecionado o modelo “GPT-4o with Canvas” no ChatGPT, toda vez que ele enviar alguma mensagem que demande que o modelo escreva um texto ou um código, uma tela se abre na lateral direita da página - como você pode ver abaixo:

É bem parecido com os Artifacts do Claude.

O texto/código, ao invés de ser escrito no chat (como uma resposta tradicional), é gerado nesta tela lateral.

A tela é interativa, isso significa que o usuário pode apagar e adicionar texto a ela, editar a formatação (colocar texto em negrito, itálico, título) e selecionar partes do texto para perguntar sobre o assunto para o ChatGPT ou pedir para ele alterar algo.

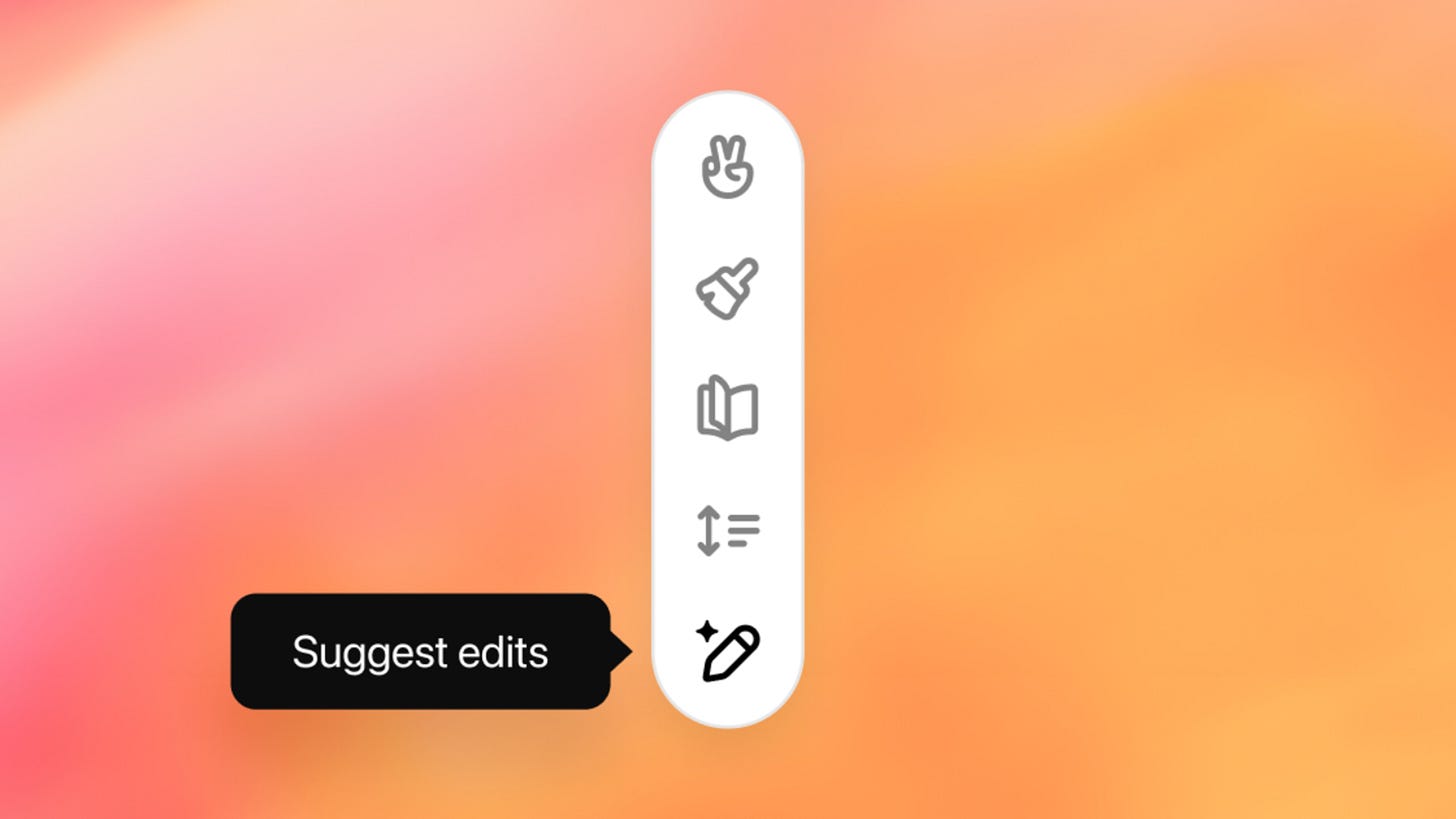

Além disso, para escrita o Canvas oferece uma série de atalhos de edição com AI. Basta clicar no botão no canto inferior direito para acessar os seguintes:

Sugestão de edições: com esse atalho, o ChatGPT fornece feedback sobre o texto, propondo melhorias específicas em trechos destacados;

Ajuste do comprimento: permite que o usuário expanda ou encurte o texto, ajustando o nível de detalhe;

Mudança no nível de leitura: altera a complexidade do texto, ajustando-o para diferentes públicos, de jardim de infância a pós-graduação;

Polimento final: revê o texto para que ele esteja gramaticalmente correto, coerente e com a clareza necessária;

Adição de emojis: insere emojis relevantes e relacionados ao seu texto.

Já para as tarefas de escrita de código, os atalhos são um pouco diferentes:

Revisão de código: com esse atalho, o ChatGPT oferece sugestões para melhorar o código, corrigindo problemas de sintaxe e otimizando trechos;

Adição de logs: insere instruções de log para ajudar na depuração, facilitando a identificação de erros e o entendimento do fluxo de execução;

Comentários no código: gera comentários automáticos para tornar o código mais compreensível;

Correção de bugs: detecta e corrige erros de forma automática, oferecendo soluções prontas ou orientações para ajustes manuais;

Portabilidade de linguagem: converte o código para diferentes linguagens de programação, como JavaScript, Python, Java, etc.

Para tornar o Canvas possível, a OpenAI treinou o GPT-4o para que ele agisse como um parceiro criativo, aprendesse quando é um bom momento para abrir a tela lateral, e fosse capaz de fazer edições direcionadas ou reescrever completamente os textos e códigos.

No geral, é uma funcionalidade muito legal. Para aqueles que utilizam o ChatGPT para redação ou programação, eu recomendo fortemente que experimente.

É realmente um processo criativo bem mais fluido e simples.

O Canvas está em fase de beta - um período de testes - e vai melhorar bastante nas próximas semanas.

E tem bastante o que melhorar.

O primeiro aspecto de melhoria é a capacidade de rodar o código que ele gerou, como o Claude faz. Isso, pois o Canvas apenas gera o código, sem coloca-lo para rodar, o que não permite que o usuário veja de forma rápida e simplificada o resultado do que foi gerado.

Essa funcionalidade é bem importante e deve ser implementada muito em breve.

Outro aspecto que pode melhorado diz respeito às sugestões de edição que o ChatGPT dá - a qualidade delas ainda não é muito boa.

Além disso, o Canvas poderia ser capaz de gerar textos maiores e permitir edições mais avançadas nestes textos, como a inserção de imagens.

De qualquer forma, o novo modelo está disponível para os assinantes dos planos pagos do ChatGPT e estará disponível para os demais usuários ao final de seu período de Beta.

É sempre bom ver o ChatGPT recebendo atualizações e melhorando como uma ferramenta de produtividade.

State of AI Report 2024

O State of AI Report 2024 acaba de ser publicado.

O relatório foi desenvolvido pela Air Street Capital (uma firma de investimentos focada em startups de AI) e cobre os principais desenvolvimentos no universo das Inteligências Artificiais neste ano.

O documento tem mais de 200 páginas e é bastante amplo, tratando desde as principais pesquisas na área até os desdobramentos do mercado e da política.

Desta maneira, não convém tratar aqui do relatório em sua totalidade - nossa retrospectiva cumprirá melhore este papel. Mas separei algumas de suas observações e insights interessantes que encontrei:

Convergência de desempenho: os modelos de AI estão cada vez mais próximos uns dos outros em termos de desempenho. O GPT-4, da OpenAI, que liderou por muito tempo, foi alcançado por modelos como Claude 3.5 Sonnet, Gemini 1.5 Pro e Grok 2.

Esta redução na distância entre os modelos da OpenAI e os modelos do mercado poderia até indicar que a empresa está perdendo sua vantagem.

Mas eu não diria isto. A OpenAI já mostrou com o lançamento do Sora e do o1 que tem AIs muito poderosas internamente e só não tem pressa para lançá-las.

Tempo de inferência: falando em o1. O seu lançamento marcou a adição de uma nova variável à equação de capacidades dos modelos de AI - o tempo de inferência.

Ou seja, o tempo que o modelo leva para “pensar” antes de gerar uma resposta passou a ser um fator decisivo na qualidade de suas respostas.

O o1, com seu grande tempo de inferência, conseguiu atingir um nível de desempenho em tarefas complexas e de raciocínio nunca antes visto.

Porém, este novo modo de pensar os modelos demanda muito poder computacional e custa caro.

Modelos de código aberto em ascensão: o Llama 3.1, da Meta, atingiu um novo paradigma ao ser o primeiro modelo de código aberto a alcançar os principais modelos fechados, como o GPT-4o e o Claude 3.5 Sonnet.

Esse marco fomenta ainda mais os avanços na área.

Modelos compactos e eficientes: estando vendo modelos de AI cada vez menores e com desempenhos cada vez mais satisfatórios.

Modelos do nível do GPT-3.5 agora podem rodar em smartphones.

Essa tendência é incrível e deve se manter nos próximos meses e anos.

NVIDIA no topo: os GPUs da NVIDIA continuam a dominar o mercado de hardware para AI, estando por trás dos principais modelos do mercado.

A demanda por seus produtos é tão alta - e a concorrência é tão baixa - que a empresa se tornou a mais valiosa do mundo há alguns meses.

E esse domínio não dá sinais de estar chegando ao fim - a demanda por chips continua crescente e a NVIDIA parece estar muito a frente de seus competidores.

Custos menores: apesar da grande demanda por poder computacional, os custos dos modelos de AI para o usuário final estão caindo drasticamente.

O GPT-4o-mini, por exemplo, é 100 vezes mais barato de usar do que o GPT-4, e o Gemini 1.5 Pro também viu seus preços caírem 76% do seu lançamento até hoje.

Foco em Produto e Monetização: As empresas de AI estão aumentando o foco na criação de produtos atraentes e funcionais, ao invés de apenas desenvolver os modelos por trás deles.

A OpenAI, por exemplo, vem melhorando o design do ChatGPT e adicionando mais funcionalidades, a fim de torná-lo mais completo e atrair mais usuários.

Essa mudança de foco reflete a necessidade das startups de AI encontrarem maneiras sustentáveis de monetizar seus modelos.

Produtos de AI ganham tração: Os produtos que são “AI-first” estão demonstrando cada vez mais capacidade de gerar receita e reter clientes. Plataformas como Synthesia, que oferece geração de vídeo com AI, e ElevenLabs, que fornece geração de áudios com AI, são exemplos de negócio que estão crescendo de forma acelerada.

Essa tendência indica que a AI está finalmente começando a gerar valor real e duradouro para as empresas e os consumidores.

Estas são algumas das observações interessantes que os autores do relatório observaram este ano.

Para ler o relatório na íntegra, basta clicar aqui.

No geral, não há nada muito novo ou surpreendente para quem já acompanha as nossas newsletter com frequência. Contudo, é uma visão geral bem legal e nos ajuda a enxergar um pouco melhor tudo que já aconteceu neste ano e as tendência que estão se formando.

Os autores do relatório também deram algumas previsões sobre o que acham que acontecerá no ano que vem. Duas que eu achei bastante ousadas e curiosas são:

“Um artigo acadêmico gerado por um ‘cientista AI’ será aceito em uma grande conferência ou workshop de Machine Learning.”

“Uma alternativa de código aberto ao OpenAI o1 irá o superar em uma série de benchmarks de raciocínio.”

Vamos aguardar para ver.

Na última semana do ano postarei uma retrospectiva completa do ano e minhas próprias previsões para 2025. Então fique ligado!

Indicações

ChatGPT App para Windows

Baixe o app do ChatGPT em seu computador, antes apenas disponível para Mac, agora também para Windows.

Krea

Acesse vários dos principais modelos de geração de vídeo (como Gen-3, Dream Machine, Minimax e Kling) e, talvez o principal modelo de geração de imagens, o Flux, gratuitamente e em um só lugar.

Dica de Uso

O modo avançado de voz do ChatGPT agora está disponível também para usuários do plano gratuito.

Apesar de ainda haver a limitação de minutos de conversa por dia, o novo modo de conversa por voz é muito poderoso.

As aplicações para ele são inúmeras. Uma delas é utiliza-lo para treinar suas apresentações em público: apresentando-se para o ChatGPT usando o modo de voz e recebendo feedbacks.

Use o seguinte prompt para isso:

Você é a minha audiência e eu estou praticando meu discurso sobre [seu tópico]. Eu farei meu discurso e, depois de cada seção, você me fará uma pergunta, como se fossem um membro da audiência buscando esclarecimentos ou informações adicionais. Forneça feedback sobre minha apresentação, incluindo meu ritmo, tom e se estou mantendo o público envolvido. Ajude-me a ajustar meu discurso com base em seu feedback.

Isto vai te dar uma noção mais ampla do que deve ser melhorado em suas apresentações, do conteúdo à forma que ele é transmitido.

Pensamento do Dia

“AI-enabled biology and medicine will allow us to compress the progress that human biologists would have achieved over the next 50-100 years into 5-10 years.”

- Dario Amodei

Por hoje é só!

Se está gostando do nosso conteúdo ou tem algum feedback para dar, sinta-se livre para responder o e-mail ou nos mandar mensagem nas redes sociais. Vamos adorar ler!

Aproveita para nos seguir no Instagram e no Tiktok (@revolucao.ai)!

Não se esqueça de compartilhar a newsletter com um amigo para ganhar prêmios!

Tenha uma ótima semana e até semana que vem!