#78 Modo de Voz Avançado Liberado no ChatGPT, AIs Chegando em Hollywood e Atualizações no Gemini 1.5

Seja bem-vindo(a) a mais uma newsletter do Revolução AI. Aqui você não perde nada sobre o universo das Inteligências Artificiais Generativas!

A edição de hoje está cheia de assuntos interessantes e relevantes! Os temas de hoje são:

Modo de Voz Avançado liberado no ChatGPT; AIs chegando em Hollywood; Atualizações significativas no Gemini 1.5; Preveja o futuro com essa AI; Crie designs com essa ferramenta de AI da Adobe.

News

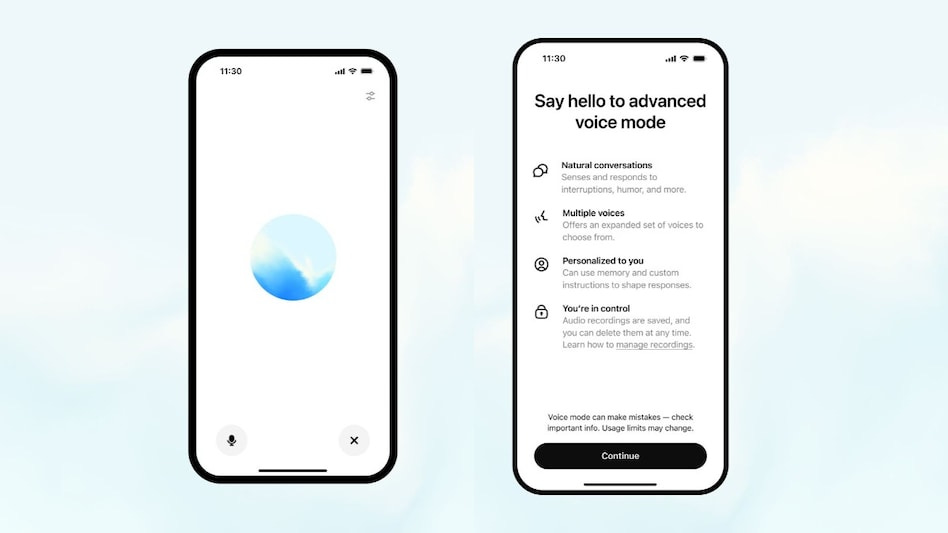

Modo de Voz Avançado liberado no ChatGPT

A OpenAI acaba de disponibilizar o Modo de Voz Avançado do ChatGPT para todos os assinantes de seus planos pagos.

Para quem não está se lembrando do Modo de Voz Avançado (Advanced Voice Mode ou AVM), o seu lançamento ocorreu em maio deste ano, no evento OpenAI Spring Updates, no qual a OpenAI anunciou o GPT-4o.

Ele nada mais é do que uma atualização da funcionalidade de conversas por voz do ChatGPT. Essa funcionalidade, que só existe no app, permite que os usuários usem a fala para se comunicar com a AI, ao invés de digitar.

A questão é que o modo de voz antigo era lento para responder e carecia de naturalidade em sua voz.

Isso, pois ele era fruto da junção de dois modelos: um de linguagem (GPT-4) e um de voz (Whisper). Assim quando um usuário enviava uma mensagem de voz, o modelo de voz transcrevia a fala, em seguida, o de linguagem respondia em texto e, por fim, o de voz gerava o áudio respondendo o usuário.

Mas com o GPT-4o isso mudou. O modelo é multimodal, isso significa que ele consegue, sozinho, interpretar e gerar textos, áudios e até imagens.

A OpenAI então substituiu o modo de voz antigo pelo Modo de Voz Avançado e colocou o GPT-4o por trás dele.

O resultado? Velocidade e naturalidade.

Na nova função, quando você conversa com a AI, ela é capaz de te responder em 320 milissegundos - o que é semelhante ao tempo de resposta humano -, permite que você a interrompa quando quiser e ainda capta as emoções por traz do tom de sua voz - se adaptando a ele.

Sem contar que as suas respostas são expressivas e extremamente humanas, tornando bem difícil perceber que é uma AI.

Dá uma olhada em como é na prática clicando aqui.

De qualquer maneira, por mais incrível que o novo modo de voz fosse, mais de três meses se passaram e quase ninguém havia recebido o acesso a ele.

E a OpenAI foi muito criticada por isso.

Mas, finalmente, nesta terça feira (24), o modelo foi amplamente disponibilizado para todos os usuários assinantes do ChatGPT Plus e Teams.

Junto disso, quase como um “pedido de desculpas”, a OpenAI também anunciou algumas novidades no Modo de Voz Avançado:

Adição de 5 novas vozes: agora o usuário pode escolher qualquer uma dentre as 9 vozes disponíveis, que variam em gênero e tom;

Melhoria na pronúncia em outros idiomas: nas versões anteriores, quando o modelo falava em outro idioma que não fosse o inglês, ele não soava como um nativo. Isso agora está bem melhor para vários idiomas (incluindo o português) e muito mais próximo do sotaque esperado;

Instruções customizadas: agora você pode adicionar instruções customizadas ao modo de voz, estabelecendo alguns detalhes que ele sempre deve saber sobre você (onde você mora, qual a sua profissão, etc) e como você quer que ele te responda (velocidade de fala, tom, etc.). Isso é bem útil e você pode customizar como quiser;

Memória: a função de memória, que, assim como as instruções customizadas, já existia no ChatGPT no modo convencional, passa a compor o modo de voz. Assim, ele pode aprender e se lembrar de informações sobre você durante as conversas por voz.

Todas essas novidades irão melhorar bastante a experiência conversacional com a AI.

Muitos usuários já estão experimentando o Modo de Voz Avançado e testando seus limites - alguns usando-o como uma companhia de leitura, outros como um afinador de guitarra, como um contador de histórias e até fazendo-o cantar ópera.

Eu mesmo já testei um pouco e posso dizer que realmente é muito legal e natural. Um grande salto em relação ao antigo modo de voz.

Contudo, um problema desse novo modo de voz são as frequentes e excessivas recusas.

Durante a conversa, não é raro que o modelo recuse solicitações triviais do usuário ou até pare a sua fala pela metade informando que suas diretrizes não o permitem falar sobre o assunto.

E isso é bem chato e atrapalha muito a fluidez das conversas.

A OpenAI tem receio de deixá-lo muito “livre” e isso gerar comportamentos perigosos ou que violem direitos autorais, etc. Mas talvez ele esteja restrito demais.

Outro problema que foi notado é o limite nas conversas por voz. Cada usuário pode conversas com o Modo Avançado de Voz apenas por cerca de uma hora por dia. E, por incrível que pareça, esse tempo passa muito rápido.

Acredito que esse limite irá aumentar em breve.

Apesar destes detalhes negativos, eu recomendo muito que você experimente esse modo de voz.

É uma experiência muito mais natural e fluida do que se comunicar digitando com o ChatGPT e abre uma série de novas possibilidades.

Por meio da voz, você consegue usar o ChatGPT para treinar a conversação em outro idioma, discutir ideias ou tópicos enquanto realiza outras tarefas - como dirigir ou passear com o cachorro - conversar sobre um livro sem interromper a leitura, preparar-se para uma apresentação e receber feedback, debater sobre suas atividades profissionais e obter conselhos ou insights, e muito mais.

Sendo criativo, pode ser extremamente útil.

Além disso, o novo modo de voz torna o ChatGPT mais acessível para pessoas com deficiências e que não tem tanta familiaridade com a tecnologia ou com digitação.

Por enquanto ele é uma função apenas dos assinantes do plano pago, porém eu não ficariam surpreso se, em alguns meses, qualquer pessoa puder utilizá-lo gratuitamente.

A OpenAI finalmente está entregando algumas de suas promessas, mas ainda falta o modo de conversa por vídeo no ChatGPT, o app para Windows e o Sora. Também gostaria de ver esse função de geração de voz via API.

Nós resta aguardar.

AIs chegando em Hollywood

Há algumas décadas, as Inteligências Artificias fazem parte de Hollywood.

Em cenários distópicos das ficções científicas, elas sempre foram retratadas nas telas de cinema. E isso não é nenhuma novidade.

A novidade é que elas estão muito perto de deixarem de ser apenas parte da trama para se tornarem peça fundamental na produção destes filmes.

Talvez nem o mais criativo dos roteiristas esperasse por isso.

Mas por que eu estou falando isso? Bom, recentemente duas notícias deixaram muito evidente isso que eu estou falando. Uma delas envolve um grande estúdio e outra um famoso diretor.

A primeira delas é que a Runway, uma das empresas pioneiras na geração de vídeos utilizando AI, fechou um acordo com a Lionsgate.

A Lionsgate, para quem nunca ouviu falar, é um dos maiores estúdios de cinema do mundo, responsável por produções como “Jogos Vorazes”, “John Wick” e “Crepúsculo”. E, além destes títulos, o estúdio já produziu mais de 20 mil filmes e séries desde a sua fundação em 1997.

Sobre a parceria entre a Lionsgate e a Runway, ela é inédita no mercado.

O acordo estabelece que a Runway irá treinar um novo modelo de geração de vídeos com AI personalizado com base no catálogo da Lionsgate. Para isso, a Runway deverá utilizar das mais de 20 mil produções audiovisuais como parte dos dados de treinamento.

A ideia é produzir um modelo que gere vídeos cinematográficos seguindo o estilo do estúdio.

Esse modelo será utilizado por diretores, produtores de vídeos e outros funcionários do estúdio para ampliar as suas capacidades criativas na produção dos filmes e séries - tanto para experimentação, quanto para geração e edição de partes de filmes.

A parceria tem tudo para dar certo.

A Runway tem avançado muito na geração de vídeos e recentemente lançou o Gen 3, seu modelo mais avançado e que está no nível dos melhores do mercado. Além disso, ela já oferece em sua plataforma uma série de ferramentas para edição dos vídeos gerados com AI, como edição localizada, controle de câmeras e o modo diretor.

Será bem interessante ver o resultado da entrada da empresa na indústria do cinema.

A segunda notícia envolve James Cameron, o famoso e renomado cineasta responsável por sucessos como “Titanic”, “Avatar” e “O Exterminador do Futuro”.

O diretor é conhecido por ser um pioneiro e inovador quando se trata de tecnologia cinematográfica e recentemente foi anunciado que ele passará a compor o conselho de diretores da Stability AI.

A Stability AI é a criadora do Stable Diffusion, uma série de modelos de geração de imagens com AI de código aberto. Além disso, ela já lançou um modelo de vídeo (Stable Vídeo), música (Stable Audio) e até de linguagem (StableLM).

Contudo, apesar da maioria dos modelos serem de código aberto e terem uma qualidade muito boa, eles ainda estão um degrau abaixo dos principais em cada segmento.

E o seu modelo de negócios independente e aberto é difícil de se sustentar em uma área que requer tanto capital para desenvolvimento. Por isso, a empresa vem passando por alguns problemas financeiros e perdeu seu CEO no início do ano.

Talvez essa nova adição ao board e possíveis parcerias com a indústria do cinema seja o que a empresa precisa para encontrar o seu caminho.

De qualquer maneria, a Stability é bem pioneira e possui muito talento humano. Junto com Cameron, que é um tecnólogo e excelente cineasta, com muitas conexões no meio, pode ser que algo bem legal seja criado.

Vamos acompanhar os desdobramentos destas duas uniões de AI e cinema que têm muito potencial.

Hollywood está prestes a ser invadido pelas AIs e isso não é uma ficção.

Atualizações significativas no Gemini 1.5

Em fevereiro deste ano o Google anunciou o seu modelo de AI Gemini 1.5.

Na época de seu lançamento, o modelo se tornou o melhor do mercado.

Alguns meses se passaram e ele recebeu atualizações pontuais e foi ultrapassado algumas vezes por modelos como o GPT-4o e o Claude 3.5 Sonnet.

Recentemente, o modelo recebeu algumas atualizações importantes que o levam mais próximo do topo no ranking dos modelos.

Mas antes de falar da atualização, vamos relembrar melhor sobre o que é o Gemini 1.5.

Bom, este modelo de AI é multimodal, isso significa que ele é capaz de interpretar áudios, vídeos, imagens e, claro, texto - apesar de só gerar texto. Além disso, ele possui uma janela de contexto de 2 milhões de tokens. Ou seja, o modelo consegue interpretar, de uma só vez, 2 horas de vídeo, 22 horas de áudio, mais de 60.000 linhas de código ou mais de 1,4 milhão de palavras (mais de 3000 mil páginas) que o usuário enviar.

O Gemini 1.5 possui duas versões:

Gemini 1.5 Pro: uma versão maior e mais “pesada”. É a mais capaz e cara das versões.

Gemini 1.5 Flash: uma versão menor do modelo, que é menos capaz do que a versão Pro, mas muito mas eficiente e barata.

Em termos de capacidade, o modelo maior e principal - Gemini 1.5 Pro - sempre esteve mais ou menos a par com os principais do mercado.

A sua principal vantagem é justamente a sua grande janela de contexto - que é dez vezes maior que qualquer outra. E isso faz muita diferença.

Sobre o acesso, a melhor forma de acessar este modelo é através do Google AI Studio, não pela ferramenta Gemini. O Google AI Studio, apesar de ter uma interface menos amigável por ser feita para desenvolvedores, é bem fácil de utilizar e permite que você acesse o Gemini 1.5 Pro e o Flash gratuitamente. Se você nunca entrou nessa plataforma, eu recomendo que experimente.

Dito isso, vamos voltar ao assunto dessa notícia.

Começando pelas novidades do Gemini 1.5 Pro, a nova versão recebe o nome de Gemini 1.5 Pro-002 e traz melhorias gerais em qualidade, mas principalmente em tarefas de matemática, raciocínio e processamento de contexto longo.

Isso fica evidente quando se compara o desempenho da versão antiga com a nova do Gemini 1.5 Pro:

No teste geral MMLU-Pro, o 002 alcançou 75.8%, contra 69.0% da versão anterior. Em testes de matemática, como o HiddenMath, o Pro-002 saltou de 28.0% para 52.0%. Finalmente, sua capacidade de processar informações em longos contextos melhorou de 70.5% para 82.6% quando testada no benchmark MRCR (1M).

Quando comparado com o GPT-4o, por exemplo, o modelo realmente exibe uma performance superior em tarefas matemáticas, mas não supera o modelo da OpenAI em todos os testes.

Se compararmos com o o1, lançado recentemente, fica claro que o Gemini 1.5 Pro, por mais que muito melhorado em matemática e raciocínio, ainda está uma categoria abaixo dele:

No GPQA diamond, que mede raciocínio em vários domínios científicos, o Gemini 1.5 Pro-0002 pontua 59,1%, enquanto o o1 fez 78%. No MATH, o o1 faz 94.8% contra os 86.5% do Gemini.

Mesmo assim, é uma atualização expressiva que coloca o modelo em uma posição de liderança em vários testes de sua categoria.

O Gemini 1.5 Pro-002, além de ficar melhor, também ficou mais barato.

O Google reduziu 64% no preço dos tokens de entrada e 52% nos tokens de saída para prompts menores que 128 mil tokens. O que é excelente para quem utiliza o modelo para construir suas próprias aplicações via API.

Junto disso, a nova versão se recusa menos a responder o usuário em questões que considera “sensíveis”. Esse era um problema ao usar o Gemini, então essa é uma novidade importante.

Todas estas novidades que mencionei sobre o Pro, também se aplicam ao Gemini 1.5 Flash, que na nova versão 002 também está desempenhando melhor em geral e principalmente em tarefas matemáticas, enquanto teve a sua usabilidade aprimorada e preço reduzido.

No geral, essas novidades não são as mais empolgantes mas são bem interessantes.

Se você quiser testar as novas versões do modelo é só clicar aqui para ir ao Google AI Studio.

Ah, e um detalhe: essas versões foram treinada para darem respostas mais curtas e diretas, então se você quiser respostas mais detalhadas, lembre-se de incluir isso no seu prompt.

Indicações

FiveThirtyNine

“Qual a probabilidade de algo acontecer?”. Essa AI faz previsões com precisão superior a de especialistas humanos.

Adobe Express

Essa ferramenta de AI da Adobe permite que você crie designs de alta qualidade, com muita rapidez.

Dica de Uso

As AIs podem te ajudar muito no seu negócio.

Seja pensando de forma estratégica:

“Realize uma análise PEST abrangente para uma empresa de [setor] operando em [localização]. Examine os fatores políticos, econômicos, sociais e tecnológicos que podem impactar o negócio. Forneça insights detalhados e recomendações estratégicas com base em sua análise.”

Ou te ajudando a entender e atender melhor seus clientes:

“Ajude-me a mapear a jornada do cliente para um [tipo de cliente] comprando [produto/serviço]. Identifique cada ponto de contato, as metas e emoções do cliente em cada estágio e potenciais pontos problemáticos. Ofereça sugestões para aprimorar a experiência do cliente ao longo da jornada.”

Esses são só dois exemplos. Basta ser criativo e usar das AIs disponíveis para pensar no seu negócio como um todo e em todas a áreas que podem ser melhoradas.

Pensamento do Dia

“Technology brought us from the Stone Age to the Agricultural Age and then to the Industrial Age. From here, the path to the Intelligence Age is paved with compute, energy, and human will.”

- Sam Altman

Por hoje é só!

Se está gostando do nosso conteúdo ou tem algum feedback para dar, sinta-se livre para responder o e-mail ou nos mandar mensagem nas redes sociais. Vamos adorar ler!

Aproveita para nos seguir no Instagram e no Tiktok (@revolucao.ai)!

Não se esqueça de compartilhar a newsletter com um amigo para ganhar prêmios!

Tenha uma ótima semana e até semana que vem!