#61 LLaMA 3 Lançado e Alcançando o GPT-4, AI Automatizando Pesquisas Científicas e Atualizações Importantes na API da OpenAI

Mais uma semana de avanços no universo das Inteligências Artificiais Generativas!

E, como aqui você não perde nada do que acontece, essa edição está recheada de assuntos interessantes e relevantes. Os temas de hoje são:

LLaMA 3 lançado e alcançando o GPT-4; AI automatizando pesquisas em ciências sociais; Atualizações importantes na API da OpenAI; Gere áudios com AI; Encontre a AI perfeita para cada tarefa.

News

LLaMA 3 lançado e alcançando o GPT-4

Em janeiro deste ano, falamos na newsletter sobre o novo foco de Mark Zuckerberg e da Meta (Facebook): alcançar AGI e torná-la open source - em outras palavras criar uma Inteligência Artificial tão capaz quanto qualquer ser humano, em todas as tarefas, e tornar o seu código disponível para qualquer um acessar.

Um objetivo muito ambicioso e até difícil de acreditar.

De qualquer forma, naquela época, a Meta já havia lançado uma série de modelos de AI (de geração de imagens, áudios, textos, etc.), mas o seu principal modelo de linguagem, o LLaMA 2, tinha capacidades comparáveis ao do GPT-3.5 Turbo.

Então havia um longo caminho até AGI.

No entanto, na semana passada, a Meta lançou o LLaMA 3 e mostrou que está realmente aproveitando de todos os seus recursos humanos, financeiros e computacionais para desenvolver seus modelos.

A nova geração de seu grande modelo de linguagem é comparável aos principais modelos do mercado, como GPT-4, Gemini 1.5 e Claude 3, e vem inicialmente em duas versões: 8B e 70B.

Isto é, uma versão de 8 bilhões de parâmetros, extremamente pequena e eficiente, capaz de funcionar em computadores comuns - não requerendo muito poder computacional - e outra versão de 70 bilhões de parâmetros, ainda considerada pequena (o GPT-4 tem cerca de 2 trilhões de parâmetros), só que mais capaz.

Ambos modelos foram treinados em um conjunto de dados de 15 trilhões de tokens, uma quantidade de informação 7 vezes maior do que o usado para treinar o LLaMA 2.

Falando de desempenho - o que interessa de fato - , quando testado nos principais benchmarks do mercado, o LLaMA 3 8B superou todos os seus concorrentes com o mesmo número de parâmetros e o LLaMA 70B superou o Gemini 1.5 Pro e o Claude 3 Sonnet em praticamente todos os testes:

A versão 70B também conseguiu superar o GPT-4 em alguns desses benchmarks, como o MMLU e o HumanEval.

Além disso, em um dos principais rankings que compara o desempenho dos chatbots de AI em diversas tarefas - o LMSYS Chatbot Arena- , o LLaMA 3 se encontra na sexta posição em tarefas gerais e em segunda posição em tarefas em inglês - isso, pois o modelo tem um desempenho superior quando opera em inglês (devido ao seu treinamento).

São números realmente incríveis, considerando o quão pequeno e leve o modelo é.

Sobre o acesso, como mencionei, as duas versões do LLaMA 3 podem ser acessadas e baixadas gratuitamente por aqui. Mas se você não programa, pode experimentar e testá-las - também de forma gratuita - por aqui.

E o modelo também está sendo integrado ao Meta AI, o novo “ChatGPT” da Meta. O Meta AI ainda não está disponível para o Brasil, mas caso você resida no exterior ou use VPN pode acessá-lo via web ou pelas redes sociais da Meta (Facebooks, WhatsApp e Instagram) entrando em “@meta.ai”.

Mas isso não é tudo sobre o LLaMA 3: o melhor está por vir.

Uma terceira versão do modelo - maior e mais poderosa - está sendo treinada e será lançada nos próximos meses. Ela terá 400 bilhões de parâmetros e, de acordo com dados de testes do modelo pré-treinado e falas de Zuckerberg, superará o GPT-4 e o Claude 3 Opus em todos os testes.

A Meta também planeja, em um futuro próximo, trazer multimodalidade (capacidade de trabalhar com imagens, áudios, vídeos) para seus modelos, melhor desempenho em outras linguagens e maiores janelas de contexto.

Essas atualizações, incluindo o LLaMA 3 400B, também devem ser lançadas com o código aberto.

E isso é extremamente positivo para o ecossistema, uma vez que fomenta inovações, e para nós, consumidores, pois barateia o acesso à tecnologia e tira o monopólio de empresas como Google, Microsoft e OpenAI.

Vamos torcer para Mark Zuckerberg continuar lançando AIs de ponta e tornando os modelos acessíveis a todos, rumo a uma AGI de código aberto.

AI automatizando pesquisas em ciências sociais

As Inteligências Artificiais estão automatizando as pesquisas científicas!

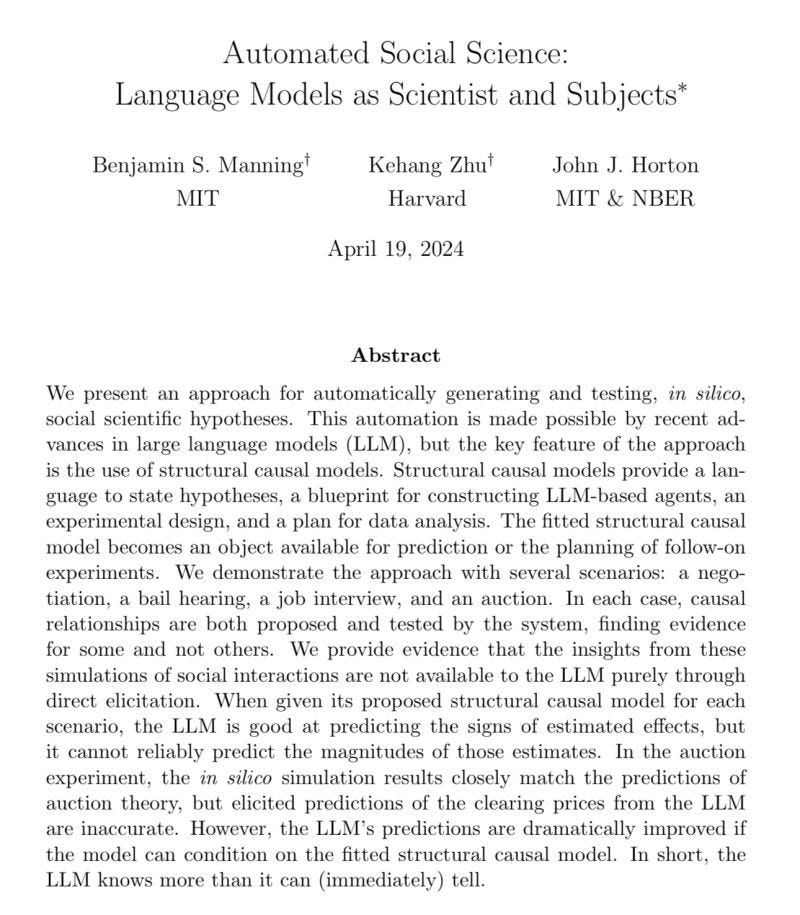

Um estudo recente desenvolvido por pesquisadores da Harvard e do MIT, buscou investigar se as AIs Generativas são capazes de conduzir pesquisas científicas no campo das Ciência Sociais, gerando e testando hipóteses de forma autônoma e automática. E os resultados foram muito interessantes!

Basicamente, a ideia foi testar se um sistema que utiliza Inteligência Artificial consegue agir como pesquisador - levantando hipóteses sobre uma situação específica e elaborando um experimento para testá-las na prática - e como objeto de pesquisa - assumindo o papel de seres humanos em simulações de situações sociais.

Para colocar isso na prática, os pesquisadores desenvolveram um sistema computacional que une grandes modelos de linguagem (LLMs), como GPT-4 e Claude, com modelos causais estruturais (SCMs) - ferramenta para representar e analisar relações de causa e efeito.

Esse sistema deveria executar 7 passos para concluir a pesquisa científica de maneira autônoma e bem sucedida:

Determinação de cenário: o sistema começa gerando uma descrição básica de um cenário social (por exemplo, “duas pessoas negociando” ou “uma entrevista de emprego”).

Geração de hipóteses: a AI propõe agentes relevantes para criar uma simulação do cenário escolhido, resultados prováveis e causas potenciais, formando um SCM.

Construção de agentes: cada AI assume o papel de um agente na simulação (por exemplo, “comprador” e “vendedor”) e recebe os atributos com base nas variáveis da simulação (por exemplo, “orçamento pessoal”, “apego ao objeto à venda”).

Design do experimento: o sistema determina a ordem de fala de cada agente de AI e variações nos atributos de cada um deles para cada simulação.

Execução do experimento: agentes alimentados por AI interagem em cenários simulados (por exemplo, “um agente de AI tenta comprar uma caneca de outro agente”) e suas conversas são gravadas.

Coleta de dados: cada agente de AI é entrevistado após cada simulação para medir os resultados.

Análise de dados: O sistema analisa os dados coletados usando o SCM pré-especificado para estimar as relações causais (por exemplo, “foi percebido, com base no resultado das simulações, que quando o apego emocional do vendedor ao que ele vendia influenciou na venda do objeto”)

Todas essas etapas são feitas pelo sistema, de maneira autônoma.

Com isso, colocando o sistema em ação, os pesquisadores testaram-o em quatro cenários diferentes:

uma negociação por uma caneca,

uma audiência de fiança,

uma entrevista de emprego para advogado,

um leilão de arte.

Em cada cenário, o sistema gerou e testou múltiplas hipóteses em simulações, chegando a conclusões interessantes e coerentes com teorias estabelecidas. Por exemplo, no cenário do leilão, o sistema descobriu que o preço final era fortemente influenciado pelo orçamento máximo dos licitantes, o que está de acordo com a teoria do leilão.

O resultado foi realmente muito bom.

Em termos de custo, o valor total que esses quatro experimentos demandaram foi cerca de US$ 1.000. E ele levou 5 horas para ser executado.

Ambos números são bem baixos, considerando os recursos demandados nesse tipo de pesquisa científica.

E as principais vantagens desse sistema incluem a clareza e precisão, a capacidade de identificar relações causais por meio de experimentos controlados e a replicabilidade dos resultados. Além disso, o sistema permite a interação do pesquisador humano, em colaboração com a AI, em todas as etapas do processo, garantindo controle e flexibilidade.

Mas vale ressaltar que o sistema tem suas limitações e ainda pode ser aprimorado, afim de gerar hipóteses mais complexas e gerar simulações mais elaboradas, capazes de captar mais nuances do comportamento humano.

No entanto, é possível vislumbrar, em um futuro muito próximo, sistemas como estes sendo empregados em cada vez mais pesquisas científicas e nos mais diversos campos, não só nas Ciências Sociais.

Com isso, graças às AIs, a produção de conhecimento está prestes a se tornar muito mais barata e mais rápida.

Atualizações importantes na API da OpenAI

Há duas semanas, a OpenAI lançou uma nova versão do GPT-4 Turbo.

Essa atualização melhorou o modelo GPT-4 em suas capacidades de escrita, matemática, raciocínio lógico e programação, além de tornar as suas respostas mais rápidas e “direto ao ponto”.

Uma melhoria relevante, mas não tão impressionante como os anúncios que estamos acostumados.

Seguindo na mesma linha, na última quarta-feira, a OpenAI divulgou a nova versão da Assistant API.

Para quem não sabe, a Assistants API é a plataforma da OpenAI que permite que desenvolvedores criem assistentes de inteligência artificial personalizados e os integrem em suas próprias aplicações. Esses assistentes são como os Custom GPTs, mas pra quem quer integrar a tecnologia fora da interface do ChatGPT.

Os Assistants podem ser criados para cumprir tarefas específicas e, além de estarem conectados ao GPT-3.5 e GPT-4, eles são capazes de acessar bases de dados customizadas, interpretar código e executar funções.

Os principais problemas que muitas pessoas - incluindo eu - encontravam usando a Assistant API eram: limitação na quantidade de arquivos que o assistente poderia consultar (apenas 20), baixa qualidade e consistência nessas consultas e pouco controle sobre o comportamento e respostas do assistente.

Aparentemente, boa parte desses problemas acaba de ser solucionado com a nova API.

Isso, pois as principais novidades da Assistants API V2 são:

Aprimoramento da ferramenta de consulta de documentos: possibilidade de fazer upload até 10.000 arquivos na base de dados para consulta de cada assistente, um aumento de 500 vezes em relação a versão anterior. Junto a isso, a arquitetura da ferramenta de busca nas bases de dados foi refeita, o que tornou a busca muito mais veloz e precisa.

Controle do uso de tokens: agora é possível delimitar o número máximo de tokens que o assistente gera por resposta e no número de tokens que ele utiliza como contexto para gerar suas respostas. Isso garante que o desenvolvedor do assistente controle os seus gastos com muito mais efetividade.

Personalização dos parâmetros do assistente: agora é possível definir os valores para Temperatura e Top P do modelo, ambos definem o quão aleatório e criativo o modelo deve ser. Controlar a Temperatura, principalmente, é fundamental para fazer com que o modelo se comporte como o desejado para cada caso específico.

Essas são as novidades mais interessantes e relevantes que separei, mas para ler tudo sobre a Assistant API v2, basta clicar aqui.

No geral, elas tornam o Assistants muito mais úteis e customizáveis do que eles eram antes. E é importante ver esse tipo de melhoria na infraestrutura da OpenAI, que está se preparando para receber em breve, o GPT-4.5 ou 5.

Indicações

OptimizerAI

Gere qualquer som de maneira gratuita com essa ferramenta de Inteligência Artificial.

What AI Can Do Today?

Digite uma tarefa que deseja executar e encontre a AI ideal para te ajudar com isso.

Dica de Uso

Se você trabalha em uma empresa e quer uma forma de se destacar, uma ótima maneira é se tornando uma referência em AI.

Algumas ideias que você pode aplicar para alcançar isso são:

Criar uma biblioteca (em um docs) com os melhores prompts ou comandos que você já testou nas AIs para auxiliar no seu trabalho e compartilhar com os seus colegas de empresa;

Listar e ensinar a usar as melhores ferramentas de AI que você usa no seu dia a dia;

Criar um GPT (disponível via ChatGPT Plus) e alimentá-lo com os principais documentos da empresa (manuais de treinamento, políticas, guias, processos, cursos);

E por aí vai!

Essas ideias são apenas para inspiração, mas as possibilidades são muitas. Basta ser criativo e experimentar o máximo possível.

Pensamento do Dia

"We're moving into a period when, for the first time ever, we may have things more intelligent than us."

- Geoffrey Hinton

Por hoje é só!

Se está gostando do nosso conteúdo ou tem algum feedback para dar, sinta-se livre para responder o e-mail ou nos mandar mensagem nas redes sociais. Vamos adorar ler!

Aproveita para nos seguir no Instagram e no Tiktok (@revolucao.ai)!

Não se esqueça de compartilhar a newsletter com um amigo para ganhar prêmios!

Tenha uma ótima semana e até semana que vem!