#83 Tudo o que Aconteceu em Dezembro sobre AI

Seja bem vindo(a) a mais uma edição da newsletter do Revolução AI!

Antes de tudo, um feliz ano novo a todos!

Estivemos um pouco sumidos neste final de 2024. Com já cheguei a mencionar anteriormente, estamos passando por algumas mudanças (positivas) internas e ajustando nossa newsletter para que ela caiba na nossa rotina e continue a agregar valor pra todos vocês.

Para 2025, nossas newsletters semanais ficarão um pouco menos extensas - isso irá garantir a sua assiduidade e será melhor para a maioria de vocês que muitas vezes não têm tempo de ler as versões mais longas.

Mesmo com o tamanho reduzido, a qualidade e relevância se manterão. E nosso inbox estará sempre aberto para quando quiserem aprofundar sobre algum tema ou assunto.

Sobre o formato, ele seguirá o mesmo: três ou quatro notícias, duas indicações, uma dica de uso e um pensamento do dia.

A única exceção é a edição desta semana. Para a presente versão, pensei em fazer uma mini retrospectiva do mês de dezembro para cobrir as principais notícias e atualizações nesse período que ficamos ausentes.

Agradecemos pela compreensão e esperamos que gostem do novo formato!

Sem mais delongas, fiquem com a newsletter da semana:

News

Novidades no ChatGPT

Em dezembro a OpenAI realizou o “12 days of OpenAI” - durante doze dias, a empresa realizou live streams no YouTube, onde anunciou pelo menos uma novidade em cada uma das lives.

Esses 12 dias de novidades antes do Natal nos proporcionaram uma série de lançamentos e atualizações importantes. E eu vou mencionar, durante essa newsletter, as mais relevantes.

Várias destas novidades envolvem o ChatGPT.

A OpenAI anunciou que o seu modo de busca, o ChatGPT Search, agora está disponível para todos os usuários.

Para quem não se lembra do ChatGPT Search, a ferramenta de busca funciona como qualquer outra que use Inteligência Artificial: você faz a pergunta, o modelo pesquisa na internet por você e te responde com base nas informações mais relevantes que encontrou, basicamente fazendo um “resumo” de tudo.

Ela fica dentro do ChatGPT e para ativá-la basta clicar no botão “Search” antes de enviar sua mensagem.

Outra funcionalidade do ChatGPT que agora está aberta a todos os usuários é o Canvas. Aqui falamos mais sobre ele, mas é uma ferramenta que permite escrever e editar textos e códigos pelo CharGPT com muito mais facilidade.

Eu já utilizo muito o Canvas e acho que vale a pena experimentar.

A OpenAI também anunciou um novo plano pago para o ChatGPT - e o preço é bem salgado…

Em Setembro, já falamos que a OpenAI pensava em lançar planos de maior valor e isto finalmente aconteceu.

O novo plano se chama ChatGPT Pro e custa 200 dólares por mês. Por 10 vezes o valor do plano Plus, ele dá direito a mais limites de uso para o Sora (modelo de vídeo que vamos falar mais para frente na newsletter) e para o o1 (modelo de raciocínio que também vamos entrar em detalhes adiante) e, além de acesso ao o1 pro mode.

No geral, pelo o que entrega hoje, esse plano não vale a pena para quase ninguém. Mas isso pode mudar em breve, caso a OpenAI lance novos modelos e disponibilize apenas para este plano. Vamos aguardar.

Google lança novo modelo e anuncia projetos ambiciosos

O Google não quis ficar para trás da OpenAI no mês de Dezembro e também fez uma série de anúncios interessantes.

Um deles foi o lançamento do Gemini 2.0 Flash. O modelo de AI é o primeiro da nova linha de modelos Gemini 2.0 - que virão para substituir as versões Gemini 1.5.

O Gemini 2.0 Flash é a versão mais leve, eficiente e barata - e menos capaz - dentre os 2.0 que serão lançados (Pro e, talvez, Ultra), mas mesmo assim, superou o modelo mais capaz do Google, o Gemini 1.5 Pro, em praticamente todos os testes.

Além de sua incrível capacidade em relação ao tamanho/custo, o modelo é capaz de compreender textos, imagens, vídeos e áudios, ao mesmo tempo em que consegue gerar textos, imagens e áudios. Apesar de isto não ser inovador (o GPT-4o tem essas capacidades), são capacidades incríveis para um modelo que tem uma janela de contexto de mais de um milhão de tokens.

Sendo capaz de processar uma quantidade enorme de informações de uma só vez e ainda gerar conteúdo em tantas modalidades, as aplicações para o modelo são inúmeras.

Para acessar o modelo, basta ser assinante do Gemini Advanced ou acessar o Google AI Studio (é gratuito). O modelo estará disponível de forma mais ampla em janeiro, quando outras versões (maiores e mais capazes) também serão lançadas.

Estou ansioso por isso.

Mas não para por aí. O Google mencionou que o Gemini 2.0 possui capacidades de “agente”, isto é, raciocínio apurado, longa memória e habilidades de planejamento.

Essas capacidades o capacitam para ser como um agente e realizar ações e tarefas complexas para os usuários de forma autônoma na internet.

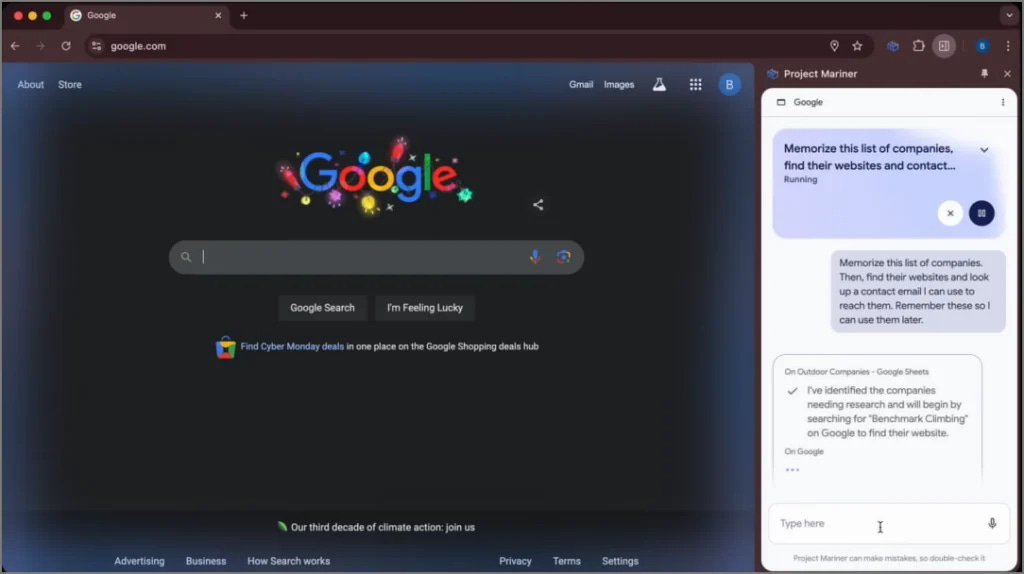

Por conta disso, ele viabiliza dois projetos ambiciosos que o Google vem desenvolvendo: Mariner e Jules.

O Project Mariner, uma extensão do Chrome que, quando habilitada, permite que o modelo de AI navegue e realize tarefas na internet para o usuário - basta dar os objetivos e comandos para tal.

É bem semelhante ao Computer Use, do Claude.

O Google afirma que o projeto está em fase de testes, mas que o modelo já supera todos os demais do mercado em suas habilidades.

O outro projeto evolvendo agentes é o Project Jules - que consiste em um agente de programação.

Semelhante a ferramentas como Devin, Cursor e Replit Agent, o agente do Google agirá como um desenvolvedor de software, programando e resolvendo problemas relacionados a código de forma autônoma.

Para acessar este projeto, basta se cadastrar na waitlist e aguardar ser chamado.

No geral, são projetos ambiciosos que valem a pena ficarmos de olho.

Modelos de raciocínio em ascensão

No primeiro dos 12 dias de lançamentos, a OpenAI anunciou que o o1, o seu modelo especializado em raciocínio avançado - treinado para passar mais tempo pensando nos problemas antes de responder - já está disponível para todos os usuários dos planos pagos do ChatGPT.

Até aquela data, só haviam sido lançadas duas versões menos capazes do o1, a preview e a mini.

Junto com este anúncio, a empresa também apresentou o “pro mode” do o1. Este modo só está disponível para assinantes do ChatGPT Pro e, quando ativado, faz com que o modelo o1, que já passa um tempo significativo pensando antes de responder, pense por ainda mais tempo, dedicando mais poder computacional para aquela solicitação específica.

Assim, o o1 com “pro mode” pensa ainda mais “pesado” nas questões, aumentando a qualidade e precisão de suas respostas. Contudo, este aumento é ligeiro e faz sentido apenas para problemas extremamente difíceis, onde cada porcentagem conta.

Se essas novidades do o1 foram reveladas no primeiro dia, no último dia tivemos o anúncio do o3.

O o3 é a mais nova versão de modelos da série “o” e vem para assumir o posto de melhor modelo de raciocínio do mundo.

Mas não deveria ser o2? Sim, mas por problemas com direitos de nome, a OpenAI teve que ir direto para o 3.

Na prática, o nome não muda nada - o o3 é o sucessor do o1 e ele é simplesmente impressionante. Não há melhor adjetivo para ele do que impressionante.

O modelo atinge resultados que nenhum outro modelo sequer chegou perto de conseguir - igualando e até superando, em alguns casos, a performance humana. Dá uma olhada em alguns resultados em benchmarks:

No Epoch Frontier Math - composto de uma série de desafios matemáticos extremamente difíceis - o modelo conseguiu uma pontuação de 25,2%. A melhor pontuação no teste por qualquer outro modelo até então era de 2%.

Em um teste composto por questões científicas de nível PhD, o GPQA Diamond, no qual experts humanos acertam cerca de 70%, o o3 acertou 87,7%.

Além disso, no SWE-bench, feito para avaliar a capacidade dos modelos em resolver problemas reais de programação, o o3 atingiu 71,7%, enquanto o o1, sua versão anterior, atingiu 48,9% (o que já era um número incrível).

Por fim, no ARC-AGI, um dos testes mais difíceis do mundo para modelos de AI, que contém questões de raciocínio abstrato, relativamente fáceis para humanos e muito difíceis para modelos, o o3 conseguiu uma pontuação recorde de 87,5% de acerto.

Para fins comparativos, a performance de um humano médio é de cerca de 75% e a melhor pontuação de um modelo, antes do o3, tinha sido do o1e era de apenas 32%.

Tudo indica que estamos cada vez mais perto de desenvolver uma Artificial General Intelligence (AGI). Isso quer dizer que talvez leve apenas alguns meses para que tenhamos uma AI com capacidades iguais ou superiores as humanas em todas as tarefas economicamente valiosas.

Os impactos disto são sem precedentes e podemos esperar que isso acelere a pesquisa e desenvolvimento em diversas áreas do conhecimento.

Voltando a falar sobre o o3, vale mencionar mais uma vez que essa série de modelos “o” é especializada em raciocínio e performa em alto nível em tarefas científicas, exatas, não se saindo melhor que os modelos do nível GPT-4o em tarefas mais subjetivas, como de humanidades ou escrita.

De qualquer forma, o o3 estará disponível para os usuários do ChatGPT nos primeiros meses de 2025. E estamos ansiosos para testar.

Modelo “nível GPT-4o” por uma fração do preço”

Falando de modelos no “nível GPT-4o”, um novo modelo chinês da empresa DeepSeek acaba de ser lançado e superar os demais modelos em praticamente todos os testes.

O modelo se chama DeepSeek V3, e é um modelo de linguagem 671 bilhões de parâmetros que segue uma arquitetura Mixture-of-Experts (MoE). A sua janela de contexto é de 128 mil tokens e ele consegue interpretar imagens e textos, mas apenas gerar textos.

O modelo se destaca em dois aspectos principais: performance e acessibilidade.

Em termos de performance, quando testado nos principais benchmarks do mercado e comparado com modelos como GPT-4o, Claude 3.5 Sonnet e Llama 3.1 (vale lembrar que esse tipo de modelo não deve ser comparado com modelos como o o1 ou o3), ele se saiu melhor que todos eles em praticamente todos os testes.

O DeepSeek V3 ficou apenas atrás do Claude no MMLU-Pro, no GPQA-Diamond e no SWE-Bench.

Uma performance excelente.

Já sobre a acessibilidade, outro ponto de destaque, o modelo tem código aberto, podendo ser baixado e utilizado por qualquer pessoa gratuitamente.

Além disso, é possível usar o modelo sem pagar nada pela plataforma da DeepSeek e, pagando menos de 10 vezes o preço do GPT-4o, ele pode ser usado através da API.

É um custo benefício excelente, que compensa experimentar e mostra que a China não está tão atrasada na corrida das AIs.

Novos e incríveis modelos de geração de vídeos.

Falando agora de modelos de geração de vídeo com AI, em dezembro tivemos avanços significativos.

Começando pelo mais importante deles, o Sora. O modelo de vídeo da OpenAI foi finalmente lançado (quase um ano depois de ser anunciado pela primeira vez).

Em um dos “12 dias de OpenAI”, a empresa disponibilizou o modelo para todos os assinantes do ChatGPT acessarem.

O Sora se encontra em sora.com. Na plataforma os usuários podem gerar vídeos de até 20 segundos e 1080p de resolução, em diferentes formatos/proporções. Os vídeos podem ser gerados a partir de comandos de texto ou de imagens/vídeos pré-existentes.

A plataforma tem uma usabilidade muito boa e é possível criar vídeos de maneira bem customizada utilizando funcionalidade de storyboard (na qual o usuário pode determinar o que acontece em cada segundo do vídeo que será gerado).

Quanto a qualidade dos vídeos gerados, eles ainda estão longe de estarem perfeitos: os vídeos nem sempre respeitam as leis da física ou fazem sentido - mas a qualidade está bem a par ou melhor que os outros modelos de geração de vídeo.

Se você assina o ChatGPT Plus, tem 50 vídeos por mês para gerar, se é assinante do Pro, tem 500 vídeos. É bem legal criar com o Sora, então esses créditos acabam rápido.

Falando de outro modelo de geração de vídeos com AI, o Google acaba de anunciar o Veo 2.

O modelo ainda não está disponível de forma aberta, mas os resultados de vídeos gerados com ele postados por alguns usuários indicam que talvez ele seja até melhor do que o Sora.

Ao que tudo indica, os vídeos gerados por ele são mais consistentes e seguem as leis da física de forma mais precisa do que qualquer outro modelo - o que é excelente.

Você pode aplicar para ter acesso prioritário ao modelo por aqui.

Outro modelo de AI de geração de vídeos lançado no período foi o Hunyuan Video. Com 13 bilhões de parâmetros e código aberto, ele é capaz de gerar vídeos de alta qualidade a partir de comandos de texto.

O modelo se coloca como o melhor modelo de vídeos open source e você pode acessá-lo por aqui.

Por último, outro avanço na área de geração de vídeos com Inteligência Artificial que vale menção é da Higgsfield.

Essa nova ferramenta de AI promete transformar a visão e as ideias dos usuários em vídeos de longa duração prontos para serem assistidos.

Isso é possível pois ela possui agentes/modelos de AI especializados em cada parte da produção: redação de scripts, atuação de personagens, cenário, cinematografia e edição. Todos estes agentes são coordenados para realizar a visão do usuário.

No site da empresa, você pode ser alguns vídeos produzidos com a ferramenta e entrar na lista de espera para acessá-la.

Grok aberto a todos

Em meados deste mês, o Grok, chatbot de AI do Elon Musk que fica dentro do X (Twitter), teve o seu acesso aberto a todos os usuários.

Antes, ele só podia ser acessado por assinantes do X, o que limitava muito o seu uso pela maior parte das pessoas. Mas isso mudou e agora qualquer um pode usá-lo gratuitamente pelo X.

O Grok tem o modelo Grok-2 por trás de sua geração de texto e o modelo Aurora por trás de sua geração de imagens. A qualidade, tanto dos textos, quanto das imagens geradas, é bem boa não ficando muito atrás dos concorrentes.

Mas o mais interessante no Grok é o fato de estar conectado ao X, podendo buscar por informações em tempo real na rede social e na internet como um todo. Isso é muito útil, uma vez que abre a possibilidade, aos usuários, de gerar insights sobre temas atuais, observar tendências e responder de maneira extremamente atualizada.

No geral, é uma boa ferramenta para experimentar, principalmente para geração de imagens e pesquisa de assuntos bem atuais.

ElevenLabs lança agente de vendas capaz de fazer ligações

A ElevenLabs, empresa por trás de um dos melhores modelos de geração de voz e áudio em geral, acaba de lançar um agente de voz para lidar com ligações pelas empresas.

O agente se chama Conversational AI e capaz de desenvolver interações naturais e envolventes com os usuários por meio de voz em diversas plataformas, como web, aplicativos móveis ou telefone.

Ele combina transcrição de fala (Speech-to-Text), modelos de linguagem (LLMs), e conversão de texto em fala (Text-to-Speech), com funcionalidades adicionais, como detecção de interrupções, garantindo conversas fluidas e dinâmicas.

Junto disso, ele suporta múltiplos idiomas, pode integrar-se a bases de conhecimento existentes e executar chamadas de API para acessar dados ou realizar ações em tempo real

A ElevenLabs afirma que ele é bem personalizável e de simples configuração - mas envolve certo nível de programação.

O Conversational AI pode ser aplicado para lidar com demandas e ligações relativas a suporte ao cliente, agendamento de compromissos e vendas.

A proposta é interessante, mas na prática é bem possível que ele não seja tão consistente e não funcione de forma tão “humana”, sendo possível que o cliente detecte que esta falando com uma AI. Além disto, o seu custo é um pouco alto: cerca de 60 centavos por minuto de conversa.

Mas todos estes problemas são temporários e é questão de tempo até que ferramentas de AI como esta dominem o campo das chamadas comerciais.

AI como simuladores do nosso mundo

Nossa newsletter já está ficando demasiada extensa, mas não poderia deixar de mencionar brevemente os avanços no campo das AIs que simulam o nosso mundo.

Esse campo das AIs simuladoras de mundo é uma área emergente e diz respeito aos modelos que são/serão capazes de gerar verdadeiros universos simulados e interativos que replicam as leis da física do nosso mundo.

O avanço desse campo é fundamental para a robótica (gerar dados para treinar os robôs), para a geração de vídeos e até para a indústria de jogos.

Recentemente, tivemos alguns avanços na área:

Genie 2: a segunda versão desse “world model” do Google. Ele é capaz de gerar universos interativos a partir de comandos de texto. O usuário descreve o cenário que deseja gerar e o Genie 2 cria um ambiente 3D cujo o usuário pode interagir nele (como em um jogo) por até um minuto.

World Labs: semelhante a Genie 2, o modelo da empresa gera cenários interativos a partir de imagens. Basta fornecer uma imagem e a cena interativa 3D é gerada.

Genesis: criado a partir de um esforço coletivo de mais de 20 grandes laboratórios de pesquisa, o Genesis é uma ferramenta que combina modelos de AI com simulações físicas para criar mundos virtuais super realistas em 4D, ideal para robótica e inteligência artificial. É rápido, eficiente e fácil de usar, permitindo treinar robôs de forma mais rápida e realista.

Avanços realmente incríveis em um campo que irá crescer muito em 2025.

Por hoje é só!

Se está gostando do nosso conteúdo ou tem algum feedback para dar, sinta-se livre para responder o e-mail ou nos mandar mensagem nas redes sociais. Vamos adorar ler!

Aproveita para nos seguir no Instagram e no Tiktok (@revolucao.ai)!

Não se esqueça de compartilhar a newsletter com um amigo para ganhar prêmios!

Tenha uma ótima semana e até semana que vem!