#63 Tudo Sobre o Lançamento do GPT-4o - Modelo Multimodal e Gratuito da OpenAI - e 18 Grandes Novidades de AI do Google

Podemos considerar essa semana como sendo a mais importante do ano no universo das Inteligências Artificiais Generativas.

Em apenas dois dias, tivemos uma série de importantes lançamentos por parte OpenAI e do Google. São tantos lançamentos relevantes, que resolvi que a sessão de notícias da edição de hoje será dedicada exclusivamente a tratar deles!

A corrida das AIs nunca esteve tão viva!

Então prepare-se, pois a newsletter de hoje está muito completa! Os temas de hoje são:

Tudo sobre o lançamento do GPT-4o - modelo multimodal e gratuito; 18 grandes novidades de AI do Google; Faça gravações de voz e converse com elas usando AI; Crie materiais visuais para apresentações com AI.

News

Tudo sobre o lançamento do GPT-4o - modelo multimodal e gratuito da OpenAI

Nessa segunda-feira, 13 de maio, ocorreu o OpenAI Spring Updates.

Neste breve evento, a OpenAI anunciou o seu mais novo modelo de AI, o GPT-4o, o novo app do ChatGPT para desktop e o novo modo de conversas com voz e vídeo no ChatGPT.

Além disso, a empresa está liberando o acesso gratuito à esse novo GPT-4o.

Antes de entrar em detalhes sobre todos os lançamentos, já aviso de antemão que eles são muito impressionantes - principalmente se considerarmos o que está por vir.

Bom, sem mais delongas, vamos falar primeiro do novo modelo de AI.

GPT-4o

O novo modelo da OpenAI recebe o nome de GPT-4o. O “o” em seu nome significa “omini”, fazendo referência ao fato dele ser o primeiro modelo multimodal da empresa.

Até então, o GPT-4 só era capaz de interpretar textos e imagens. Mas a versão “omini” foi treinada do zero utilizando textos, imagens e áudios. Com isso, o modelo é capaz de interpretar basicamente qualquer modalidade de informação - vídeos, imagens, áudios e textos -, assim como gerar textos, imagens e áudios.

Se antes no ChatGPT, o GPT-4 era responsável por lidar com textos, o DALL-E 3 por gerar imagens e o Whisper por lidar com áudios, agora é possível fazer tudo isso apenas utilizando o GPT-4o.

Essa multimodalidade traz algumas vantagens muito significativas para o modelo.

A primeira delas é velocidade de geração, uma vez que o modelo não depende de outros modelos para gerar sua resposta. Então ele interpreta e gera imagens e áudios com muito mais rapidez.

A segunda delas é qualidade. E essa vantagem vale um aprofundamento.

Em termos de interpretação de imagens enviadas pelo usuário, a qualidade dos resultados produzidos pelo GPT-4o foi superior a todos os modelos do mercado, incluindo o Gemini 1.5 e o Claude 3 Opus.

Sobre trabalhar com áudios, o novo modelo produz menos erros em suas transcrições, traduz melhor que qualquer modelo do mercado e - o principal - é capaz de captar nuances nas falas dos usuários, como entonações e emoções.

Na mesma linha a qualidade do que é gerado nessas modalidades também melhorou, uma vez que os áudios e falas geradas pelo omini são muito mais naturais e realistas - como você verá adiante.

Finalmente, a qualidade das imagens geradas pelo GPT-4o são simplesmente incríveis - não por que são mais bonitas ou criativas do que as do DALL-E 3, mas por refletirem o comando do usuário com muita precisão.

Por exemplo, agora é possível gerar uma imagem de um personagem fictício e depois gerar novamente o mesmo personagem (que se mantém consistente) em vários momentos da história ou gerar imagens com longos parágrafos de textos, soletrados perfeitamente.

Veja os resultados para entender melhor do que estou falando, mas essa nova capacidade realmente me impressionou.

Passando agora para as habilidades “intelectuais” do GPT-4o, o quão capaz ele é desempenhando tarefas e aplicando os seus conhecimentos e como ele se compara ao GPT-4?

Quando testado nos principais benchmarks do mercado, o novo modelo superou todos os demais modelos em praticamente todos os testes.

Dentre estes testes, ele estabeleceu um novo recorde no MMLU, com a pontuação de 88,7% - indicando melhorias em seu raciocínio - e agora lidera com muita folga em tarefas matemáticas.

Lembra que na semana passada falei de dois modelos de AI misteriosos que a OpenAI estava testando secretamente e que eram melhores que o GPT-4 em tarefas de raciocínio? Pois é, é bem provável que algum deles era o GPT-4o.

Ainda sobre as capacidades do modelo, ele já assume a primeira posição, com uma margem significativa, do LMSYS Chatbot Arena - uma plataforma feita para testar e comparar e ranquear o desempenho dos chatbots de AI em diversas tarefas.

Finalizando os detalhes sobre o GPT-4o, além de melhor, ele está 2 vezes mais rápido na geração de suas respostas e custa 50% do GPT-4 Turbo (preço relativo ao acesso do modelo via API).

Voz e Vídeo

A OpenAI está integrando o seu novo modelo de AI do ChatGPT e, com isso, novas possibilidades de funcionalidades foram desbloqueadas.

Assim, a empresa está atualizando o modo de voz do ChatGPT, que permite que você conduza a conversa com a AI por meio de fala.

Se você já utilizou essa função de voz, percebeu que o modelo demorava alguns segundos para te responder e respondia com pouca naturalidade em sua voz. Mas isso ficou no passado, a nova versão do modo de voz é quase mágica!

Na nova função, quando você conversa com a AI, ela é capaz de te responder em 320 milissegundos - o que é semelhante ao tempo de resposta humano -, permite que você a interrompa quando quiser e ainda capta as emoções por traz do tom de sua voz - se adaptando a ele.

Sem contar que as suas respostas são expressivas e extremamente humanas, quase impossível perceber que é uma AI.

Junto a estas conversas por voz, a OpenAI estará disponibilizando em breve a possibilidade de conversar por vídeo. O que significa que você poderá conversar como ChatGPT enquanto ele vê você, o que está ao seu redor, ou algo que queria mostrar a ele.

Veja a demo dessas novas funcionalidades clicando aqui.

Essas novas funções permitem que você use o ChatGPT como um tradutor em tempo real, um contador de histórias de dormir, um entrevistador, um guia para pessoas com problemas visuais, um tutor para crianças e adolescentes, uma companhia para pessoas solitárias, atendente de call center e por ai vai…

Desktop App

Se não bastasse tudo isso, a OpenAI também está lançando um app do ChatGPT para o desktop.

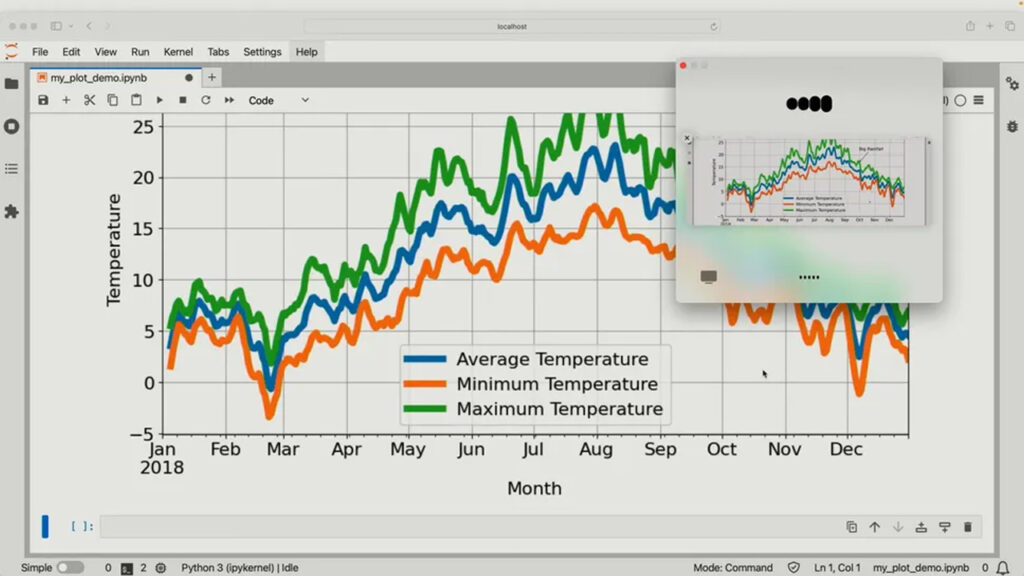

Como app, é possível tanto acessar o ChatGPT da forma tradicional, na interface que conhecemos, ou transformar o ChatGPT em um pequeno widget, como na imagem abaixo:

Mas qual a vantagem disso?

Usando dos novos recursos de visão e áudio do GPT-4o, o ChatGPT consegue ver tudo o que você faz na tela (se você permitir que ele veja, é claro), enquanto você conversa com ele e faz perguntas e solicitações a respeito do que está fazendo.

Com isso, o chatbot fica muito mais naturalmente integrado ao fluxo de trabalho do usuário, sendo uma companhia e assistente de voz sempre que ele quiser.

Olha como funciona na prática.

Infelizmente, essa novidade estará disponível apenas para computadores Mac, mas ainda nesse ano será lançada a versão compatível com o Windows. E eu não vejo a hora de testar.

Acesso Gratuito

Por fim, a cereja do bolo dos anúncios é que a OpenAI está disponibilizando esse novo modelo gratuitamente via ChatGPT.

Isso significa que qualquer pessoa agora terá acesso ao GPT-4o e a vários recursos do ChatGPT Plus, como os de conversar com imagens (Vision), enviar documentos para resumir ou analisar, pesquisar na internet (Browsing), enviar dados para gerar gráficos e análises (Advanced Data Analysis ou Code Interpreter) e acessar GPT store, um local onde você pode-se encontrar versões do ChatGPT customizadas para tarefas específicas.

Isso é fantástico e me leva a pensar sobre as razões da OpenAI estar fazendo tal coisa.

Acredito que seja três fatores: eles querem que todos conheçam e experimentem as capacidade de modelos de AI mais avançados, o novo modelo agora é muito mais barato de rodar (por isso não há tantos problemas em disponibilizá-lo de graça) e algo mais poderoso logo será lançado - afinal, os assinantes dos planos pagos precisam ter vantagens em assinar e não faz nenhum sentido disponibilizar seu melhor modelo gratuitamente.

Independente da razão, essa notícia é muito boa.

Mais perto dos Agentes

Em resumo, há um novo modelo multimodal, mais rápido, mais barato e mais inteligente que agora pode interagir de maneira super natural por voz e ver tudo que você vê dentro fora das telas, te auxiliando na execução de tarefas e sendo seu assistente pessoal 24/7. E que ainda será gratuito.

O filme Her está cada vez mais próximo de se tornar realidade e isso é, ao mesmo tempo, incrível e preocupante.

E isso ainda é só o começo…

Sempre falo sobre os agentes de AI, sistemas que além de conversarem e gerarem textos, códigos, imagens, vídeos, músicas, etc. poderão executar ações por nós. Essa é a próxima fronteira para as Inteligências Artificiais. E se você não acredita em mim, olha só o que Sam Altman escreveu em seu blog sobre o GPT-4o:

“Falar com um computador nunca foi muito natural para mim; agora é. À medida que adicionamos personalização (opcional), acesso às suas informações, a capacidade de realizar ações por você e muito mais, posso realmente ver um futuro emocionante onde seremos capazes de usar computadores para fazer muito mais do que nunca .”

O futuro é muito empolgante e ainda nem tivemos acesso ao GPT-5!

Ah, antes que eu me esqueça, o GPT-4o já está disponível para ser acessado via API e no ChatGPT para assinantes do Plus. Nas próximas semanas o novo modelo estará disponível para todos os usuários e o novo modo de voz poderá ser acessado por usuários pagantes.

18 grandes novidades de AI do Google

Um dia depois do OpenAI Spring Update, o Google realizou o Google I/O 2024 e anunciou muitas novidades de AI.

Novidades estas que vão desde atualizações sobre seus modelos até integração dessas AIs em suas aplicações e ferramentas.

O evento durou mais de duas horas de Live e eu separei tudo de mais relevante que foi falado. Dividi as novidades em áreas, para facilitar a compreensão:

Gemini 1.5

Falando primeiro das notícias relativas ao modelo de AI mais avançado do Google, tivemos duas principais:

Janela de contexto de 2M: agora o Gemini 1.5 Pro passa a ter uma janela de contexto de 2 milhões de tokens - anteriormente, essa janela era de 1 milhão.

Isso permitirá que o modelo analise o dobro de informações de uma só vez. Por enquanto, para acessar essa versão do Gemini via Google AI Studio é necessário entrar em uma waitlist.

Gemini 1.5 Flash: o Google está lançando um novo modelo "leve" otimizado para tarefas que exigem mais velocidade e menos capacidade computacional. É como o Claude 3 Haiku da Anthropic e pode ser acessado no Google AI Studio.

Gemini

Agora falando das novidades da ferramenta Gemini - é importante não confundir o modelo com a ferramenta: o Gemini 1.5 está para o GPT-4o da mesma forma que o Gemini está para o ChatGPT -, ela está passando por uma atualização importante.

O chatbot do Google tem as seguintes novidades chegando:

Janela de 1 milhão de tokens: o plano pago do Gemini, o Advanced, agora terá sua janela de contexto passando de 200 mil para 1 milhão de tokens. O que é bem interessante, mas já havia sido anunciado como um plano da empresa.

"Gems": o Google acaba de criar sua própria GPT Store. Os usuários da ferramenta poderão criar e utilizar versões customizadas e especializadas do Gemini - os Gems.

Gemini Live: essa novidade é legal. Ela é a versão do Google da modo de voz e vídeo que comentei que a OpenAI lançou.

O Gemini Live foi desenvolvido a partir do chamado Projeto Astra e é uma experiência conversacional que usa voz e vídeo para interagir com o Gemini de forma mais natural.

Diferentemente da OpenAI que demonstrou a ferramenta em ação ao vivo, o Google apenas mostrou um vídeo dela funcionando. Apesar da AI conversar de forma natural, responder relativamente rápido e até permitir ser interrompida pelo usuário, o desempenho deixa a desejar comparado com o GPT-4o.

Imagem e Vídeo

Veo: o Google acaba de lançar o seu competidor ao Sora e eu devo confessar que fiquei impressionado com alguns vídeos que esse novo modelo gerou - dá uma olhada aqui.

O modelo se chama Veo, foi desenvolvido pelo Google DeepMind e é capaz de gerar vídeos de até 60 segundos e qualidade 1080p a partir de prompts de texto, imagens e vídeos.

Imagen 3: a nova versão do modelo de geração de imagens do Google está sendo lançada. O Imagen 3 é capaz de gerar imagens realmente impressionantes, extremamente realista e mais capaz de lidar com textos nas imagens.

De acordo com o falado no evento, em experimentos internos, o Google observou que a maior parte das pessoas preferiu as imagens geradas pelo novo modelo às geradas pelos outros modelos de imagem do mercado. O que é um dado impressionante se real.

Ambos os modelos estão disponíveis no labs.google por meio de uma waitlist.

Gemini for Search

Após meses experimentando com AI Generativa na sua ferramenta de busca, o Google está dando o próximo passo na integração com AI.

Agora as buscas dos usuários serão respondidas de forma mais completa com AI, usando:

Raciocínio em várias etapas para buscar e responder questões complexas e com nuances.

Planejamento inteligente para criar itinerários de viagem, planos de refeição e etc., personalizados de acordo com preferências do usuário

Resultados de busca dinamicamente organizados pela AI em categorias relevantes para facilitar a exploração.

Quando colocado na prática isso realmente vai ser bem interessante e dará trabalho à Perplexity e ao Bing.

Além disso, ainda sobre buscas, foi anunciado que em breve será possível pesquisar enviando vídeos como input, com a AI analisando e respondendo sobre o conteúdo.

Notebook LM

A ferramenta de anotações e estudos integrada a AI do Google - que já era bem legal - está ficando ainda melhor.

Já falamos dela aqui antes e basicamente ela permite que usuários enviem documentos e textos sobre o que estão estudando e a AI usa esses arquivos para fazer resumos, guias de estudos, quizzes e responder perguntas sobre o conteúdo.

A grande novidade é que ela contará com o “Audio Overview”.

Essa nova função permite que a AI reúna tudo que você forneceu para ela e crie um diálogo de voz - entre duas ou mais AIs - discutindo os temas do material ou sugeridos pelo usuário.

Além de ouvir essa conversa para aprender mais, o usuário pode entrar no diálogo e contribuir com suas perguntas, comentários e opiniões.

Uma forma incrível e inovadora de estudar, que quero muito experimentar.

Google Workspace

Sobre o Google Workspace, além das integrações de um assistente de AI no Gmail, Docs, Meets… que já falei tantas vezes, foi anunciado algo curioso.

O “AI Teammate”: uma forma diferente de integrar AI nesses apps.

Basicamente, ele é como um colega de trabalho que tem seu próprio login no Google Workspace. Ele é um agente de AI que pode ser instruído para desempenhar funções dentro desses apps e auxiliar em tarefas como analisar emails e anexos, agendar compromissos com base em informações extraídas e até rascunhar respostas.

Basta que os funcionários da empresa conversem com ele por meio de chat.

Essa função ainda não está disponível, mas essa abordagem faz bastante sentido.

Android

Falando de Android, as próximas versões do sistema operacionais terão as seguintes integrações nativas com AI (dentre outras menos interessantes):

Integração com Gemini como assistente por voz.

Geração de imagens usando o assistente do sistema.

Modelo de AI funcionando localmente nos próprios celulares. O modelo escolhido para isso foi o “Gemini Nano”. E isso é uma novidade muito boa, pois permite acesso a AI sem estar conectado à internet, garante mais velociade nas respostas e maior privacidade e segurança de dados.

AI que detecta fraudes nas ligações telefônicas e avisa ao usuário que talvez ele esteja caindo em um golpe.

Google Photos

Finalmente, uma novidade legal do Google Photos será a possibilidade de fazer perguntas pra AI, dentro da ferramenta sobre as suas fotos.

Com isso será possível buscar fotos com mais precisão e facilidade.

De qualquer forma, essas foram as novidades do Google I/O 2024. Caso queria ver todas as novidades, basta clicar aqui para assistir ao evento na íntegra.

Muitas novidades interessantes foram anunciadas e o Google respondeu bem aos lançamentos da OpenAI, se mantendo bem vivo nessa disputa.

No entanto, o grande problema de tudo isso que o Google anunciou é que quase nada foi demonstrado ao vivo ou está disponível para ser acessado imediatamente ou em um futuro próximo.

Por enquanto falta um pouco de entrega por parte da empresa. Temos muitas promessas e expectativas altas, vamos ver se isso se traduz na realidade.

Indicações

Voice Notes

Grave e armazene qualquer coisa (anotações, podcasts, reuniões, etc.) e use AI para conversar com essas gravações.

AFFiNE

Crie incríveis materiais de apresentação com Inteligência Artificial.

Dica de Uso

Esqueça prompt engineering! A Anthropic acabou de lançar uma ferramenta que escreve prompts de alta qualidade por você.

Nessa ferramenta, tudo que você tem que fazer é escrever qual o objetivo que você deseja atingir com o seu comando e o Claude 3 irá gerar um prompt muito bom para você utilizar em outras AIs.

Dá uma olhada como é simples:

Você vai entrar em https://console.anthropic.com e fazer login.

Feito o login, você deve ir na parte de dashboard e selecionar a opção “generate a prompt”.

E então basta escrever o que deseja que a AI faça com o seu prompt, como resumir um documento, escrever um email, etc., e clicar em gerar.

Pronto! Em alguns segundos seu comando está gerado e é só copiar para usar na AI de sua preferência.

Vale lembrar que é importante verificar o comando e ajustar para que os resultados sejam mais adequados ainda.

Pensamento do Dia

Agora que todos têm fácil acesso a uma AI do nível do GPT-4, pode ser que finalmente a “chave vire” para muitas pessoas que usaram o GPT-3.5 e pensaram que AI não era nada demais.

Isso pode ser muito significativo se acontecer.

Por hoje é só!

Se está gostando do nosso conteúdo ou tem algum feedback para dar, sinta-se livre para responder o e-mail ou nos mandar mensagem nas redes sociais. Vamos adorar ler!

Aproveita para nos seguir no Instagram e no Tiktok (@revolucao.ai)!

Não se esqueça de compartilhar a newsletter com um amigo para ganhar prêmios!

Tenha uma ótima semana e até semana que vem!