#53 Dois Lançamentos e Uma Polêmica do Google, Stable Diffusion 3 e Groq - o Novo Concorrente da Nvidia

Seja bem-vindo(a) a mais uma newsletter do Revolução AI. Aqui você não perde nada sobre o universo das Inteligências Artificiais Generativas!

Os temas de hoje são:

Dois lançamentos e uma polêmica do Google; Stable Diffusion 3 - o melhor modelo de geração de imagens open source; Um novo desafiante da Nvidia no mercado dos chips de AI; Explore temas com essa AI de busca; Use os modelos da Mistral AI via web.

News

Dois lançamentos e uma polêmica do Google

Há algumas semanas, o Google vem realizando muitos lançamentos importantes: Gemini 1.0, Lumiere, Imagen 2, Gemini 1.5, etc.

Mas, desde o ano passado, a empresa vem sendo fortemente criticada por especialistas e usuários de seus produtos por conta de sua lentidão em inovar - ficando para trás da OpenAI - e por lançar produtos abaixo das expectativas.

Essa segunda razão pode ser exemplificada com a lembrança das primeiras versões do Bard, que era vergonhosamente pior do que o ChatGPT, ou com a de quando o Google forjou a demonstração do Gemini 1.0 para fazê-lo parecer muito melhor que realmente era.

Esses lançamentos e controvérsias tem sido o tema do último ano do Google.

E na última semana isso se repetiu, com dois lançamentos bem interessantes e uma polêmica envolvendo a empresa.

Dois lançamentos

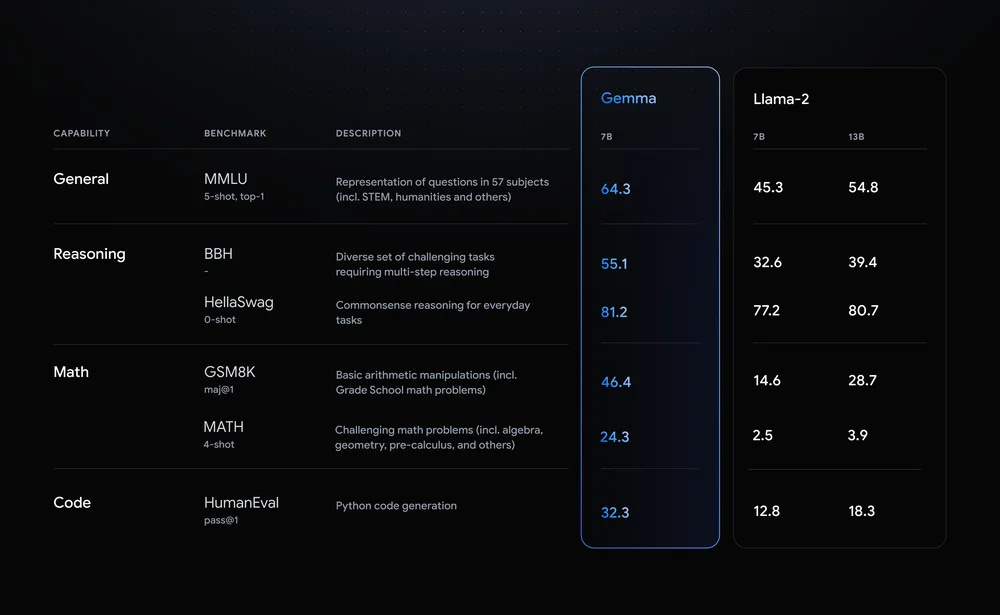

Um dos lançamentos foi o Gemma, o seu novo grande modelo de linguagem (LLM) de código aberto.

O modelo de AI vem para compor a categoria dos “pesos-leves”, uma vez que ele é um modelo bem menor do que os principais que conhecemos - tendo uma versão de 2 bilhões de parâmetros e outra de 7 bilhões.

Para fins comparativos, o GPT-3.5 tem cerca de 175 bilhões de parâmetros e acredita-se que o GPT-4 tenha por volta de um trilhão.

Esses parâmetros impactam na capacidade dos modelos e também no poder computacional necessário para rodá-los.

Isso significa que o Gemma performa de maneira inferior ao GPT-3.5, GPT-4, Claude 2 e Gemini, porém, em compensação, é capaz de rodar localmente em um computador razoavelmente bom - sem precisar de um servidor externo para isso.

Ok, o modelo é leve, barato e qualquer um pode acessar, mas o quão capaz ele é na realização de tarefas?

Compartilhando alguns componentes técnicos com o Gemini, ele faz tudo que os outros modelos fazem - gerando códigos e textos - e, como você pode ver abaixo, ele se saiu bem nos testes que realizou, superando o LLaMA 2 (7B e 13B).

Em resumo, é um modelo que é um pouco inferior ao ChatGPT-3.5, mas que é gratuito e acessível. Isto o torna uma ótima opção para criar aplicações que demandem capacidades menos complexas.

Para acessar o modelo é só clicar aqui.

O outro lançamento foi o do Genie (uma abreviação para generative interactive environments), um modelo de AI capaz de gerar ambientes interativos ou “jogáveis”.

Basicamente, a partir de uma imagem enviada pelo usuário, o Genie é capaz de imaginar e gerar um universo em 2D - estilo Super Mario - novo e interativo. Nesse universo criado, o usuário pode controlar o personagem, movendo-o como em um jogo.

É muito interessante.

O Genie foi treinado com milhões de vídeos disponíveis na internet e marca uma nova fronteira no campo da AI Generativa.

Apesar de ainda ser muito limitado, o modelo pode impactar tanto a área de jogos e simulações, quanto o desenvolvimento de futuros modelos de AI generalistas - já que, com ele, é possível gerar infinitas horas de vídeos gameplays para treinar os modelos.

Vamos acompanhar esse novo tipo de modelo e trazer atualizações.

Uma polêmica

Após duas notícias legais, é hora de falar da polêmica da vez que o Google criou.

Talvez você já saiba do que eu estou me referindo, mas vamos começar do começo:

O Gemini (antigo Bard) é o chatbot de AI do Google para rivalizar com o ChatGPT. Ele é capaz de gerar imagens, uma vez que é integrado ao modelo Imagen 2, criado pela empresa.

Na última semana, alguns usuários do Gemini perceberam que o chatbot se recusava a gerar imagens de pessoas brancas, gerando apenas fotos de asiáticos, negros, latinos ou indígenas - mesmo quando pedido para gerar imagens de figuras históricas tipicamente brancas, como Papas, vikings ou cavaleiros medievais.

Prints destas conversas com a AI foram postados na internet e viralizaram.

A repercussão foi tão negativa que o Google suspendeu a função de geração de imagens temporariamente.

Eis o que deve ter acontecido:

Em uma tentativa de ser inclusivo nas imagens geradas pelo seu modelo, o Google deve ter escrito no comando do sistema do modelo de AI algo como “sempre inclua minorias nas imagens que gerar/sempre gere pessoas de etnias x,y,z”.

Porém, essa tentativa foi exagerada (por falta de testes adequados ou pouca reflexão sobre suas consequências) e o modelo ignorou fatos históricos/geográficos e às vontades dos usuários.

O Google reconheceu que errou e disse que irá corrigir o problema. No entanto, os danos à sua reputação frente ao público são mais difíceis de consertar.

Com tantos lançamentos interessantes, parece que um dos principais rivais do gigante da busca segue sendo ele próprio.

Stable Diffusion 3 - o melhor modelo de geração de imagens open source

Ainda falando de geração de imagens com Inteligência Artificial, a Stability AI lançou, na semana passada, um dos modelos mais avançados até hoje.

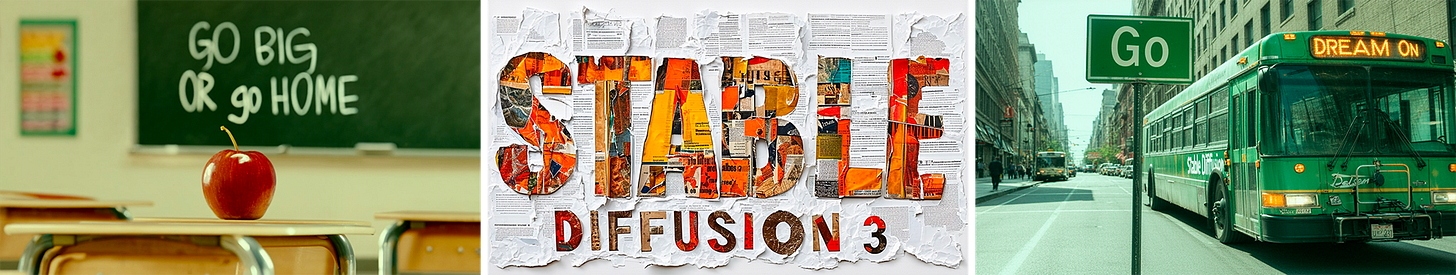

O modelo é a terceira versão do Stable Diffusion e é capaz de gerar imagens a partir de prompts de texto.

O Stable Diffusion 1 e o 2, assim como os outros modelos de AI da empresa, são de código aberto e podem ser baixados, treinados e utilizados por qualquer pessoa gratuitamente - e com sua nova versão isso não será diferente.

Os modelos da Stability já possuíam alta qualidade nas imagens criavam, sendo algumas das melhores alternativas para gerar imagens sem depender de empresas, como a OpenAI, ou para criar aplicações mais elaboradas e específicas.

E o Stable Diffusion 3 vem para se aproximar do nível dos melhores modelos do mercado - DALL-E 3 e Midjourney.

As imagens geradas por ele são incríveis, se destacando em três aspectos principais:

Alta qualidade e realismo;

Fidelidade nos textos contidos em imagens geradas;

Capacidade de seguir instruções complexas envolvendo elementos e detalhes nas imagens.

Por enquanto, os detalhes técnicos acerca do modelo não foram divulgados. O que se sabe é que ele virá em tamanhos diversos - de 800M a 8B de parâmetros -, variando a capacidade computacional necessária para rodá-lo e qualidade das imagens geradas.

Além disso, ele ainda está na fase de waitlist, então para obter acesso antecipado é só entrar aqui.

Mas em breve ele estará disponível a todos e poderemos se ele é tão bom quanto parece e se, quem sabe, ele consegue rivalizar com os dois principais modelos do mercado.

Um novo desafiante da Nvidia no mercado dos chips de AI

Se você tem o costume de ler a nossa newsletter ou de acompanhar os assuntos que envolvem as AIs, já deve ter ouvido falar dos GPUs (Graphics Processing Unit) - os chips de AI.

Eles são uma das partes fundamentais para o desenvolvimento e funcionamento dos modelos de AI como GPT-4, Sora, DALL-E 3 e Gemini.

A Nvidia, principal fabricante desses GPUs (detém cerca de 80% do mercado) foi uma das empresas que mais cresceu no último ano, ultrapassando o valuation da Amazon e da Alphabet.

Mas existe uma empresa que quer competir por parte deste valioso mercado de fornecimento de hardware para empresas de AI.

Fundada em 2016 por, um ex-Google, Jonathan Ross, ela chama-se Groq (não confunda com o Grok do Elon Musk) e desenvolveu o seu próprio chip.

O seu chip se chama LPU (Language Processing Unit) e é um novo tipo de sistema de processamento para lidar com aplicações de computação intensiva e com componente sequencial, como os grandes modelos de linguagem.

Os LPUs são projetados para lidar com esses modelos de AI e têm tanta ou mais capacidade que um processador gráfico (GPU), mas possuem vantagens na arquitetura de sua memória, o que os tornam mais eficientes e velozes.

Usando de uma explicação dada pelo GPT-4:

“As LPUs da Groq são como bibliotecários super-rápidos que podem encontrar livros (dados) rapidamente porque usam um sistema rápido (SRAM) para armazená-los por perto. As GPUs da Nvidia também são bibliotecárias, mas usam um sistema mais lento (HBM) e às vezes precisam ir mais longe para encontrar os livros, o que consome mais tempo e energia.”

Assim, a arquitetura da LPU da Groq é excelente para rodar modelos de AI, como o próprio GPT-4. Isso, pois ela permite que esses modelos gerem suas respostas em um tempo muito menor (menos de um décimo do tempo) do que se estiverem em GPUs.

Modelos de AI, na tecnologia da Groq, conseguem gerar mais de 200 palavras por segundo. Isso dá um livro inteiro em menos de 7 minutos.

A velocidade é realmente impressionante, e você pode testar isso na prática por aqui.

Essa velocidade amplia a gama de aplicações dos modelos, possibilitando melhores experiências em conversas por voz ou em que requerem longas respostas.

Por conta dessas vantagens de custo e tempo, as LPUs podem começar a serem adotadas mais amplamente pelas empresas que usam modelos de AI em suas aplicações.

E talvez a Nvidia tenha ganhado um competidor relevante, então vale a pena ficar de olho nessa disputa.

Indicações

Globe Explorer

Explore qualquer tópico usando essa ferramenta de busca que disseca os assuntos de maneira visual e lógica.

Le Chat Mistral

Acesse os modelos da startup francesa Mistral AI via web. Por enquanto em waitlist.

Dica de Uso

Uma maneira muito interessante de utilizar ferramentas de AI, como ChatGPT, Claude e Gemini, é para obter insights para problemas e desafios que enfrentamos no nosso dia a dia, principalmente no trabalho.

Para isso, basta utilizar o seguinte prompt, adaptando-o à sua área e questão:

Você é um especialista em [área de atuação] com 30 anos de experiência. O seu objetivo é ajudar as pessoas a encontrarem soluções para as questões que eles trazem para você. Você deve aconselhá-las de maneira inteligente, fazendo-as enxergar novas abordagens ou perspectivas para os problemas que enfrentam e dando-os novas ideias e insights relevantes.

Questão: [descrever situação]

Os resultados são muito bons e vale a pena experimentar!

Pensamento do Dia

“Move fast. Speed is one of your main advantages over large competitors.”

- Sam Altman

Por hoje é só!

Se está gostando do nosso conteúdo ou tem algum feedback para dar, sinta-se livre para responder o e-mail ou nos mandar mensagem nas redes sociais. Vamos adorar ler!

Aproveita para nos seguir no Instagram e no Tiktok (@revolucao.ai)!

Não se esqueça de compartilhar a newsletter com um amigo para ganhar prêmios!

Tenha uma ótima semana e até segunda!

Olá, pessoal!

Gostaria muito de ver vocês comentando e analisando a Sapiens.chat, nossa IA brazuca.

Abs!